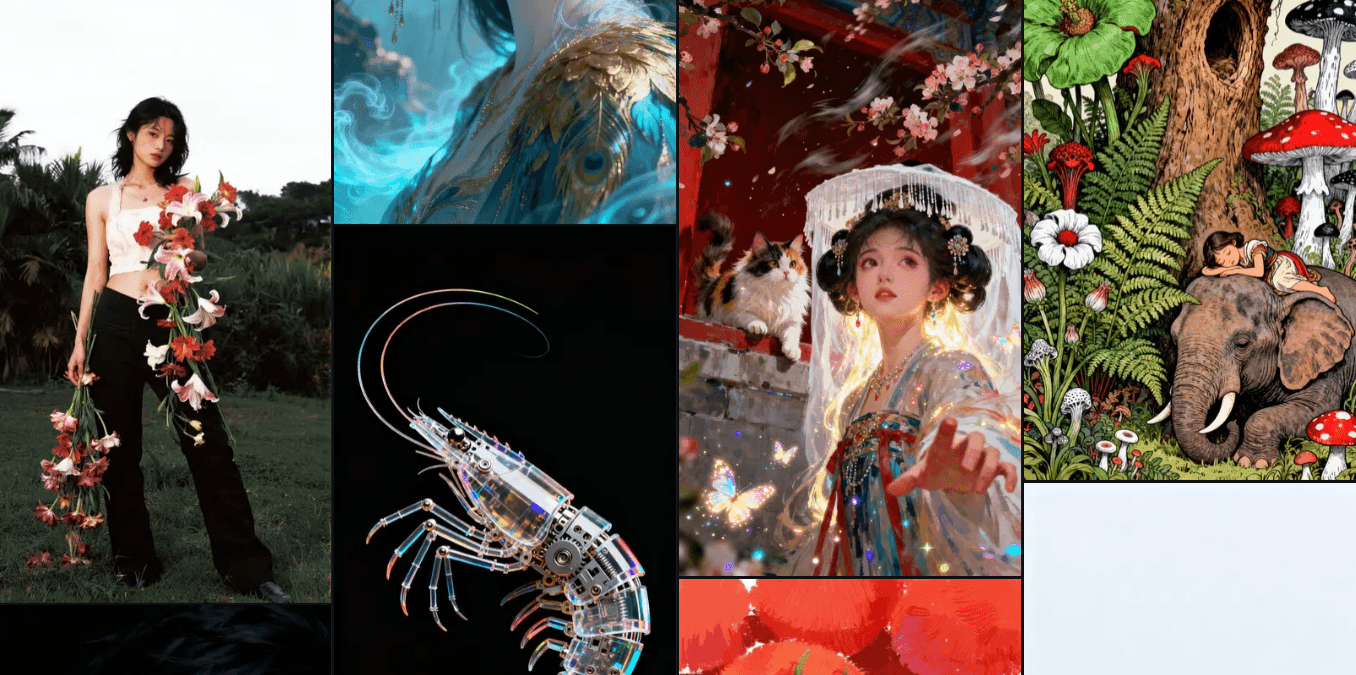

ai作图能被识别出来吗?有些一眼就能看出

现在AI画图工具满天飞,Midjourney、Stable Diffusion、DALL-E这些名字估计大家都听腻了。但有个问题挺有意思的——这些ai作图能被识别出来吗?AI作图能不能被识别出来,得看是啥水平的AI图,还有用啥方法去辨。现在技术两边都在较劲,有的图一眼就能看穿,有的却能混过专业人士的眼。

一、一眼就能看穿的AI图

新手用AI生成的图,很容易露出马脚。

最常见的是“细节崩坏”,比如画人物,手指要么多一根少一根,要么弯得跟塑料似的,关节都不对劲儿。例如“弹钢琴的女孩”,结果女孩的手像揉成一团的纸,钢琴键都歪歪扭扭,明眼人一看就知道是AI做的。

还有背景“糊成一团”,AI处理复杂场景时,经常会把远处的景物弄成模糊的色块,没有真实照片里的层次感。比如画“城市夜景”,AI生成的路灯可能是一个个光斑,没有灯杆的细节;画“森林”,远处的树木会变成一片绿,分不清哪是树叶哪是树干。

颜色也容易出问题,有的AI图颜色饱和度高得吓人,红的太红、绿的太绿,看着特别假。还有的图阴影不对,比如人物站在阳光下,影子却在头顶,完全不符合物理规律。这些破绽,别说专业工具,普通人仔细看都能发现。

二、专业工具识别,靠的是“隐形标记”

现在不少AI作图工具,会在生成的图片里加“数字水印”——不是那种看得见的logo,是藏在像素里的代码,普通人看不到,但用专门的工具一查就能发现。比如MidJourney生成的图,用它官网的检测工具上传,就能显示“由AI生成”的标记。

还有些第三方工具,比如Content Authenticity Initiative开发的检测器,能分析图片的“生成痕迹”。AI画图时,会有特定的像素排列规律,比如某些颜色的分布概率和真人画的不一样,这些规律肉眼看不出来,但机器能捕捉到。之前有个设计比赛,有人用AI生成的图参赛,就是被这种工具查出来,最后取消了资格。

不过这些工具也不是万能的,要是用户把AI图手动改一改,比如调整颜色、裁剪画面,检测准确率就会下降。有个设计师试过,把AI生成的图用PS修了修细节,再用检测器查,结果显示“疑似AI生成”,没敢百分百确定。

三、高手改的AI图识别难度翻倍

要是有人在AI生成的基础上,花大功夫手动修改,那识别起来就难多了。比如先让AI生成一张“古风女子”的初稿,再用PS调整手指细节,补画衣服上的花纹,修改背景的层次感。改完之后,别说普通人,连专业检测器都可能误判。

还有些人会把多张AI图拼在一起,再手动融合。比如想画“未来城市”,先让AI生成不同的建筑、街道、人物,再用设计软件拼起来,调整光影和透视,最后出来的图,根本看不出是拼的,识别工具也很难检测出AI痕迹。

现在AI作图技术更新太快,之前容易出的“手指崩坏”“背景模糊”问题,新的模型已经能改善不少。比如最新的Stable Diffusion 3,生成的人物手指基本能对得上,背景细节也丰富多了。

而识别技术也在升级,有的工具开始分析图片的“创作逻辑”——真人画画会有笔触的变化,AI画的图笔触比较均匀;真人设计场景会有合理的布局,AI偶尔会出现“不合理的元素”,比如在卧室里放个游泳池。这些细微的差别,正在成为新的识别依据。

不过说到底,只要有人想“藏”,就会有办法绕过识别。比如把AI图打印出来再扫描,或者多次修改调整,识别工具就很难判断。未来AI作图和识别技术,可能会像“猫鼠游戏”一样,一直较劲下去。

总的来说,普通AI图容易被识别,改得好的AI图很难辨。但随着技术发展,说不定以后连专业人士,都难分清一张图是AI做的还是手绘的了。