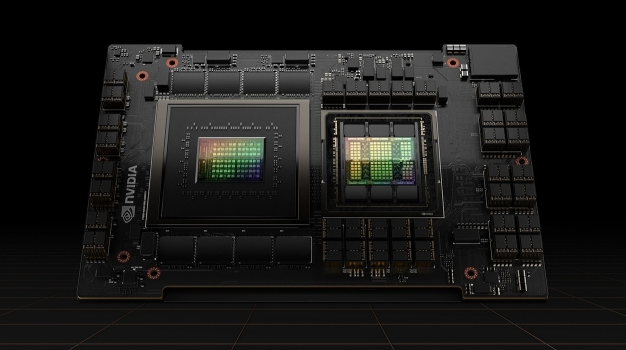

英伟达H100芯片成功升天,全球首个太空AI服务器!

11月2日,一个听起来有点疯狂的想法变成了现实——英伟达的H100 GPU被送进了太空。这块目前AI训练领域的王牌芯片,配备80GB内存,算力是以往任何太空计算机的上百倍。它要在轨道上干什么?测试AI图像分析、运行谷歌的大语言模型。更疯狂的是,这只是个开始。

这次测试搭载在Starcloud公司的Starcloud-1卫星上,这家位于弗吉尼亚的初创公司想做一件事:把地球上那些耗能巨大的数据中心,搬到太空去。听起来天方夜谭?但支持者的理由还挺充分——太空不占地、冷却几乎不耗能、也不会往大气里排放温室气体。

为什么"太空数据中心"意义重大

想想你每天的操作:发微信、存照片到云端、用ChatGPT写文章,背后都有庞大的数据中心在运转。

这些数据中心是真正的"电老虎"和"水老虎"。它们疯狂吞噬电力,需要大量水来冷却设备,还会释放热量、制造噪音、排放温室气体。住在数据中心附近的人应该深有体会。

太空环境完全是另一回事。太阳能?管够。散热?真空环境本身就是天然的冷却系统,几乎不需要额外能耗。

Starcloud的CEO Philip Johnston算了笔账:"发射火箭确实有环境成本,但之后我们在碳排放方面的节省,能达到地面数据中心的十倍。"

对一个正拼命寻找减碳方案的世界来说,这个数字相当诱人。

NVIDIA GPU如何在轨道上工作

Starcloud-1卫星大概就小冰箱那么大,但搭载的H100 GPU可不简单——它是迄今进入轨道最强悍的芯片,算力大约是之前太空芯片的百倍。

进入轨道后,这块GPU要处理卫星传回的海量数据。比如识别哪里着火了、追踪农作物长势、监测气候变化的具体指标。

以前这些数据得先传回地球,科学家们再慢慢分析。整个流程既慢又耗能。现在在轨道上直接处理,响应速度快了,决策也更精准。

这次任务还有个亮点:会测试Google的Gemma语言模型。这是大型AI模型第一次在太空跑起来。你可以想象一下,以后卫星不仅能拍照,还能"理解"它看到的东西,甚至生成报告。

Starcloud想通过在轨计算,让地球观测变得更快、更高效。毕竟当森林大火刚冒烟时,多争取几分钟响应时间,可能就能少烧几千亩林子。

Starcloud的更大野心:在太空建超级数据中心

不过说实话,这次任务只是Starcloud试水。他们真正的野心大得多。

公司计划未来在太空建造大型数据中心,用太阳能供电,靠轨道低温自然冷却。下一代系统会搭载英伟达更新的Blackwell架构GPU,性能更强、能效更高。

他们的终极目标听起来像科幻小说:建一个功率5吉瓦、跨度约4公里的轨道数据中心。这个庞然大物能承担海量AI计算任务,同时大幅降低成本和碳排放。

随着SpaceX这些公司把火箭发射成本一降再降,太空数据中心这个想法,正在从科幻变成可行性方案。

Johnston甚至预测,到2030年代,很多新建数据中心不会再建在地球上,而是直接发射到轨道运行。这个时间表听着挺激进,但考虑到十年前我们还觉得火箭回收是天方夜谭,谁知道呢?

这对你意味着什么

如果Starcloud这帮人真搞成了,影响可能比你想的大。

未来你刷视频、玩游戏、用AI写作工具时,背后的算力可能就来自头顶的太空数据中心。云服务会变得更快、更便宜、也更环保。

太空数据中心还能加速很多实际应用。灾害响应能更及时,天气预报会更准,每年能省下数百万加仑冷却用水。对那些饱受数据中心噪音和热量困扰的社区来说,也是个好消息。

从更大的角度看,这个计划证明了一件事:创新和可持续发展不是非此即彼的选择题。有时候,最环保的解决方案,恰恰是最大胆的那个。当然,太空数据中心能不能真正普及,还要看技术成熟度、成本控制、还有各种意想不到的挑战。但至少现在,H100已经在轨道上开始工作了。这个开头,还算不错。