ai动作视频是怎么做的

AI动作视频没想象中玄乎,无非就是把真人动作的逻辑,转成机器能懂的语言再倒腾回来。

一、动作蓝本

动作蓝本是必要的,你总不能让AI瞎编吧?最常见也是最专业的方式就是让真人演员穿上布满传感器的紧身衣,在专门的摄影棚里表演各种动作。

那些密密麻麻的小球状标记点会被高速摄像头精确捕捉,然后转化成数字信号。我曾经在一个游戏公司参观过这样的设备,看着演员在空荡荡的房间里"表演",而屏幕上却出现了完全不同的角色形象,而且十分丝滑。

当然,现在的技术已经进步到可以不用那些繁琐的设备了。基于深度学习的姿态估计算法能够直接从普通视频中提取人体动作信息。OpenPose、MediaPipe这些开源工具让很多小团队也能玩转动作捕捉,门槛大大降低了。

再其次,自己用手机录动作视频,或者直接用3D软件捏个小人摆姿势,都可以。

二、投喂给ai

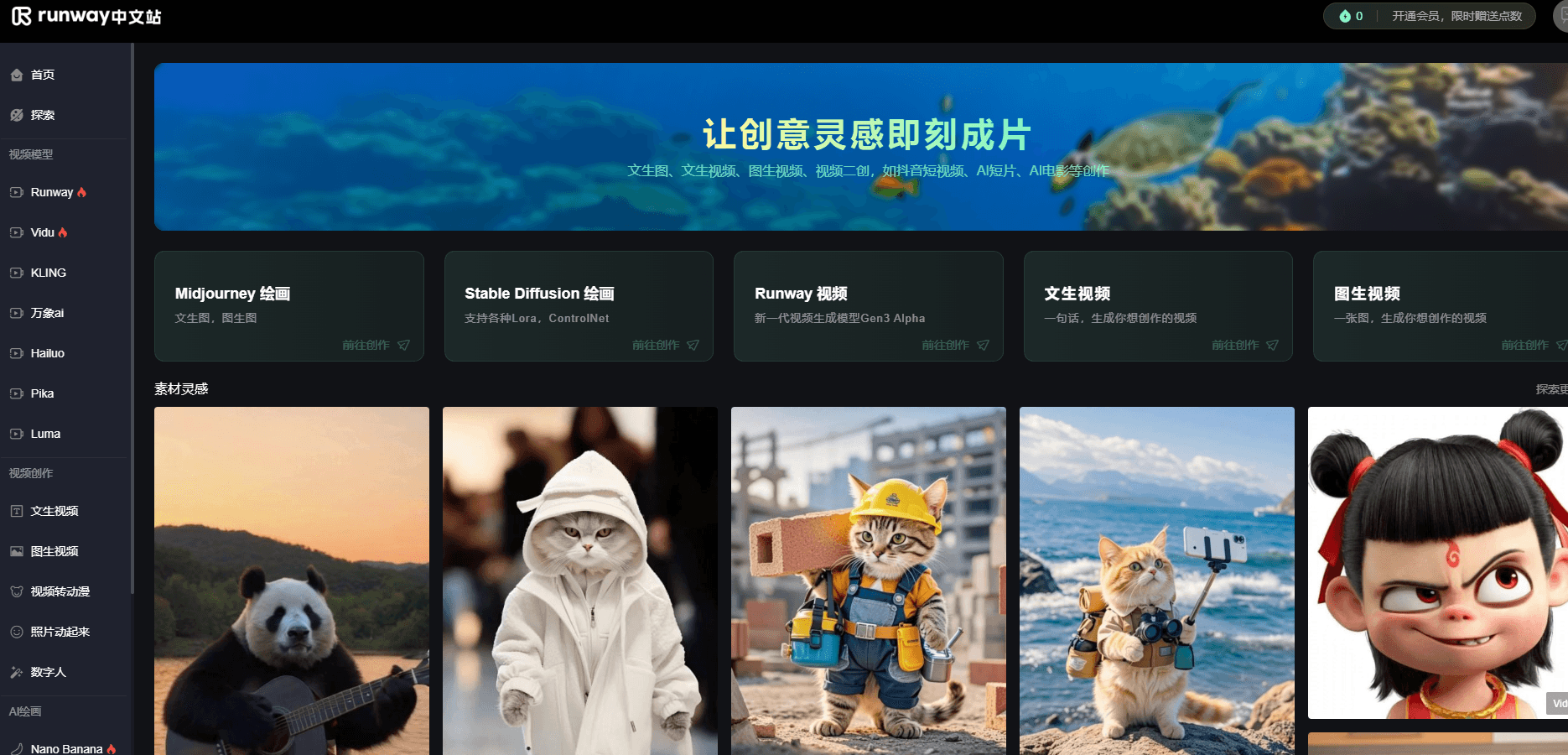

这里得选工具,常用的是Runway和PicsArt,前者出片细腻点但慢,后者傻瓜式操作适合新手。

中间最费劲儿的是“修bug”,AI有时候会犯低级错误,比如人物突然少个手指,或者脚穿模穿到地板里,这些都需要人为去修改。

三、实时渲染

实时渲染技术的突破让AI动作视频的应用场景大大扩展。以前那种需要几小时甚至几天才能渲染一帧画面的时代已经过去了。

现在利用GPU并行计算和优化的着色器,可以实现接近电影级别的实时画面效果。这让虚拟主播、在线演示、互动娱乐等应用成为可能。

四、音频同步

AI角色的嘴型要跟语音完美匹配,这需要音素识别和唇形生成算法的配合。

现在的技术已经能做到根据音频自动生成相应的口型动画,甚至能处理不同语言之间的差异。

五、后期

后期优化和调试往往占据了整个制作周期的很大比例。即使前期的动作捕捉和生成都很完美,在实际应用中还是会遇到各种问题。比如关节限制不合理导致的异常姿态,或者动作过渡不够自然等等。这些都需要技术人员逐帧检查和调整。

目前云端处理和边缘计算的结合为AI动作视频提供了新的可能性。复杂的计算可以在服务器端完成,而简单的实时交互则在本地设备上处理。这种混合架构既保证了效果质量,又降低了硬件要求。

要是做短视频,1080P、30帧就够了,选4K的话导出得等半天。还有格式,MP4最通用,别选AVI,不然好多软件打不开。