AI爆款视频有什么秘密?4步教你“扒出”门道、汲粹出新!

目录

- 前言

- 整体原则和流程

- 生成和修改AI输出的提示词

- 获取首帧图,生成尾帧图

- 文、图生视频

- 小结

在这个短视频满布时间缝隙的时代,经常会看到小伙伴发问:

“这个AI视频怎么做到连贯自然的?”“这种优质视频的提示词怎么写的?”“是要用哪个模型才能生成如此质量吗?”

基于此,本人仔细盘了盘大佬视频,整理了一些方法和技巧。不过在分享心得之前,希望大家先明确使用爆款视频的整体原则和流程。

整体原则和流程

在实操之前,大家要始终记得以下原则,否则就容易陷在视频生成困境中无法自拔:

1.你只能模仿别人的视频生成类似的视频,而不能复刻。

因为鉴于各大AI模型以抽卡形式生成视频,连大佬原版的提示词,都无法保证每次生成一模一样的视频,更何况在大佬不愿分享提示词情况下,你用AI反推的提示词生成的视频呢!

2.反推提示词的目的是为了理论和实操学习,让自己的创意更好、更快呈现,而不是剽窃他人作品。

具体来讲,反推提示词的最大作用在于反推生成流程、通过案例练习掌握思维框架、提醒自己需要准备的工具和物料、丰富提示词库、搜集和套用模板,从而帮助自己高效创作。

这里事先声明,下面引用的作品仅作为解构的素材和验证使用,目的是引导大家学习、优化提示词的技巧,并非误导大家剽窃他人创意。

原则明确后,大家还需要明确临摹爆款作品(私下)的整个流程:

文生视频:

设计让AI反推的提示词-选择AI生成和修改提示词-生成视频-自己按照提示词给出的音效音乐指导配音、剪辑。

图生视频:

设计让AI反推的提示词-选择AI生成和修改提示词-获取首帧图、(生成尾帧图:可省略)-首尾帧/单帧生成视频(边生成边修改提示词,直到生成满意的为止)-获取尾帧图、(生成下一个尾帧图:可省略)-从“首尾帧/单帧生成视频”开始循环(直到所有视频段落都生成完毕)-自己按照提示词给出的音效音乐指导配音、剪辑。

本文只讲构成一轮循环的前四个步骤。为了能更好地理解文意,大家请边看这个提示词文档边浏览下文哦~

https://lh41ozy6wa.feishu.cn/wiki/JWTEwbDBqiZRCkkxywocxNLanLf

(ps:以下视频均由AI生成)

第一步:设计让AI反推的指令

指令框架同反推图片一样,需要按照“高级角色设定+任务简述+任务分步详述+输出格式”结构来设计。

与反推图片的区别在于,反推视频的分析要素中多了音景(音效和bgm),电影化镜头设计相比画面美学多了镜头类型、镜头焦段和运镜,提示词字数限制更宽泛了。

还有就是反推较长的视频,需要将视频分段,并生成每段视频的一套提示词。

比如以下基础指令:(主体、叙事、画面、音景占比较均衡)

5秒以内的视频:

1.在分析和逆推的过程中,你必须严格遵循以下四个维度作为你的分析框架和输出标准:

(1)主角塑造与叙事性动作: 识别镜头内容(人或物或环境),并分析其行为所承载的叙事意图。

(2)环境构建与材质细节: 解构画面的环境背景,深入分析其中环境背景构成的物体(指出它的材质和纹理)、时代/风格细节。

(3)风格锚点: 识别并定义出贯穿视频的“风格锚点 (Stylistic Anchor)”

(4)电影化镜头设计:从镜头类型、镜头焦段、光影、景别、构图、色彩色调、视角、运镜、画质等要素分别进行分析。整个镜头设计用短词语描述而非句子,分析和描述需详尽,描述词需专业。

(5)沉浸式音景: 分析视频的声音设计,包括环境音、具体音效以及音乐的使用策略(或“无音乐”的选择)。

2.请对1的具体分析进行概括(600-650字之间),并按照以下格式输出你的分析结果:

【视频概述】XXX。

【主角塑造与叙事性动作】: XXX。

【世界构建与材质细节】: XXX。

【电影化镜头设计】: 【镜头类型】XXX;【镜头焦段】XXX;【光影】XXX......

【技术规格】:XXX

5秒以上的需要AI分段的视频:

请你扮演一位专业的电影分析师和顶尖的AI提示词工程师。你的核心任务是,基于我刚刚上传的视频文件,对其进行分镜解构,并为每个关键分镜逆向推导出其对应的、能够生成该画面的AI视频提示词。具体要求如下:

1.在分析和逆推的过程中,你必须严格遵循以下五个维度作为你的分析框架和输出标准:

(1)主角塑造与叙事性动作: 识别镜头中的“主角”(人或物)。其中对于人物和物体,需描述具体形象特点,并进行详细分析其动作变化情况,分析其行为所承载的叙事意图。

(2)环境构建与材质细节: 解构画面的环境背景,深入分析其中环境背景构成的物体(指出它的材质和纹理)、时代/风格细节。

(3)风格锚点: 识别并定义出贯穿视频的“风格锚点 (Stylistic Anchor)”

(4)电影化镜头设计:从镜头类型、镜头焦段、光影、景别、构图、色彩色调、视角、运镜、画质等要素分别进行分析。其中构图是核心,尤其需要严谨、深入分析。整个镜头设计用短词语描述而非句子,分析和描述需详尽,描述词需专业。

(5)沉浸式音景: 分析视频的声音设计,包括环境音、具体音效以及音乐的使用策略(或“无音乐”的选择)。

2.整合与输出: 根据视频文件中的镜头设计各要素的特点,合理划分视频段落。将以上分析结果,为每个视频段落整合并输出成一个单一、高密度的文字段落,并附上必要的技术规格。

3.请按照以下格式输出你的分析结果:

【视频概述】: 首先,对视频的叙事内容、核心“风格锚点”和音景设计进行一个简要的总体分析。

【视频段落提示词逆推】: 然后,按顺序以“段落1 (时间段)”、“段落2 (时间段)”……的格式,为视频中的每个关键镜头提供你逆向推导出的提示词。

当然你可以像反推图片一样,针对不同题材的视频,设计几套不同的反推指令。比如动作类、打斗类的视频就详细描述主体动作要求,对话聊天类的视频就详细描述主体的形象、表情和动作,简写环境要求。

第二步:生成和修改AI输出的提示词

能上传视频的AI工具就有限了。

国内常用的聊天模型(豆包、deepseek、hunyuan、kimi等)全军覆没,国外的Gemini、chatgpt、Google AI Studio倒是都可行。

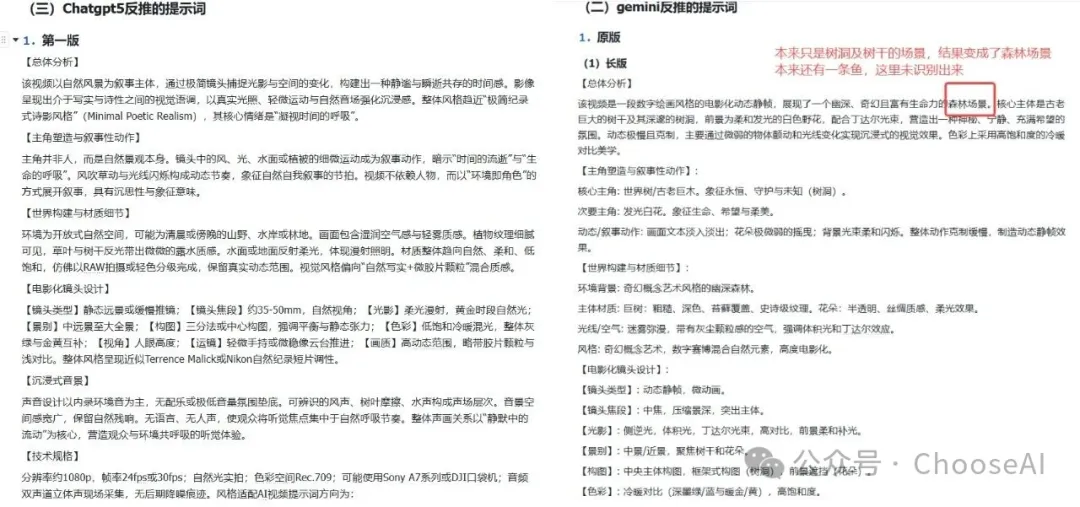

因上篇反推图片测试出Gemini反馈的画面美学提示词很细腻,画面美学在电影化镜头设计要素中占主导,主体、动作解析也不拉胯,所以还是推荐大家优先使用Gemini。

实测下来确实也是Gemini操作更方便、效果更好。

chatgpt不经提示画面解析很抽象,打斗、动作类等快速变化的视频连场景、风格大类都解析错误,比如古风武打解析为工业仓库内搏斗,并且还解析不了音景。Google AI Studio区域和语言双受限,输出的英文变成中文可能超限。

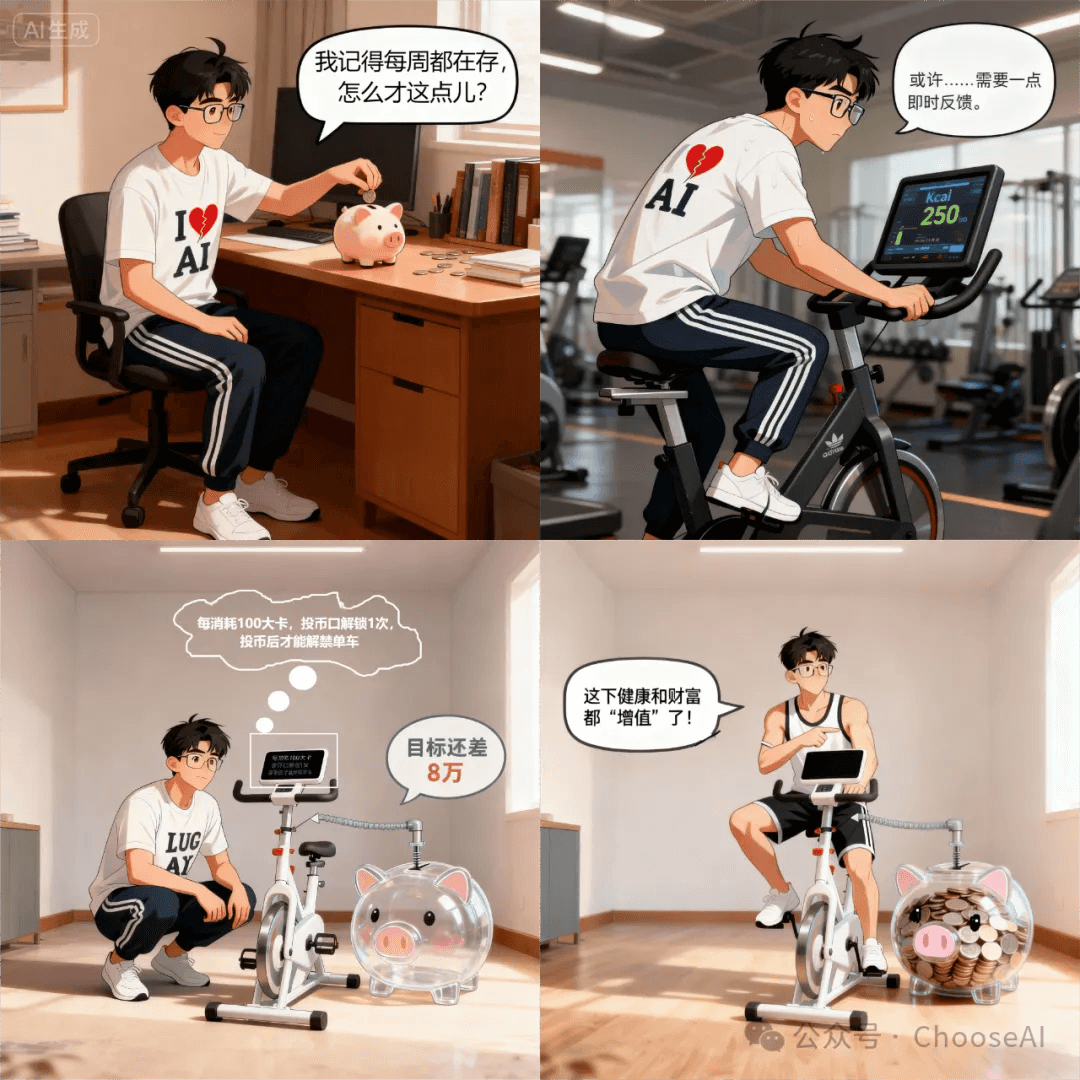

(左为gpt反推,右为gemini反推)

不过Gemini在解构视频时,尤其当没有突出的一个主体时,它对主体、构图、景别等重要要素可能解构错误,字数也可能超出要求的范围。

我使用上面基础版指令让它拆解打斗类视频时发现,它对动作拆解可能不详细,也可能不会按照要求将每5s的视频段落作为1个单位来拆解。

此时,上一步针对不同题材设计出不同的反推指令,就能发挥作用规避这些问题。

当然,更为保险的做法还是在Gemini生成提示词后优化修改。

优化提示词就是根据视频题材和叙事内容判断重点,对重要部分逐句阅读、修改。一般情况下,你需要先生成视频、验证后接着修改提示词,即优化提示词贯穿生成视频这一环节的始终。

第三步:获取首帧图,生成尾帧图

这一步仅分析图生视频所涉及的图生图技巧。

首帧图可据自己需要从以下方法中择其一获取:

1.截图参考视频作为首帧图

前提是你有清晰的参考视频,你一丝一毫都不想修改。

2.截图参考视频-图生图/变清晰

若想加入自己想法,进行局部修改,或者需要将图片变清晰,这个方法比较适合。

3.根据优化后的提示词文生图

这个更适合需要融入自己想法较多、能接受视频画面差异点多的小伙伴。若还是想更趋近参考视频,请绕开此方法。

我们为了能把控视视频走向,一般会采用首尾帧或多帧的方式生成视频,其中多帧目前是可灵1.6和即梦3.0能使用,首尾帧目前海螺和可灵的最新视频模型无法使用。

当然,若你不太在乎视频走向,或者只是生成简单视频,你也可以不用生成尾帧图。之后若需使用,直接截图用首帧生成的视频即可。

第四步:文、图生视频

文生视频和图生视频在当前这步,除了刚开始前者输入提示词、后者输入提示词+上传图片的不同之外,就都只剩下“生成视频-优化提示词”的循环。

视频生成的AI工具,常见的有国外的Veo3、midjourney,国内的即梦、豆包、海螺、可灵、通义万相、夸克造点。

此处我选用的即梦、海螺、可灵完成本次任务,接下来也仅对这仨的生成效果与特点进行分析。大家可以阅读完本文后用提示词试试其他工具。

以下是这三个工具的特点:

1.海螺

- 文生视频、单图生视频能用最新海螺2.3模型(minimax),首尾帧视频最新模型只能用海螺2.0,没有多帧图生视频的功能;

- 它的后台能自动优化提示词,且提示词简单一些(结构全,词精简),优化后生成的视频效果更好;提示词越长,优化作用越弱,视频生成效果就越依赖原本的提示词;

- 提示词输入量上限为2000字,三个工具中最高,可以选择运镜类型,且一个视频可以选择多个运镜,生成的最短时长是6s。

- 即便是非会员耗时也最短,6s视频/个10分钟之内即可生成。

- 打斗类、动作类的视频生成优势突出。

2.即梦

- 不能文生视频,首尾帧无法选择运镜;

- 有语言盲区,不像生图的4.0模型语义理解强,比如和速度、距离相关的语言;

- 图生视频提示词要求500字以内。

3.可灵

- 文生视频可用最新模型可灵2.5Turbo(可以选部分镜头语言),首尾帧能使用的最新模型为2.1,都只能选择一个运镜;

- 提示词最多可输入700字,能配音效和bgm;

- 耗时超多,尤其是非会员。它根据IP识别账号,不能同时开两个网站同时生成,加速必须买会员。非会员5s的视频,耗时2小时可以看作是起步时间。

无论是操作便捷度还是生成效果,海螺都是最好的。

大家可看看视频结果对比:

1.鱼游树洞:(文生视频)

(原版视频:由AI生成)

(短版提示词-海螺2.3生成)

(短版提示词-可灵2.5Turbo生成)

(长版提示词-海螺2.3生成)

(长版提示词-可灵2.5Turbo生成)

2.武打视频(首尾帧生视频,因个人喜好,换了验证视频中的黑衣人形象)

(原版:来源于小红书博主“木小星星”。因录屏原因,此处视频较模糊,大家可看小红书原视频)

(段落2-提示词修改版-海螺2.0生成)

(段落2-提示词修改版-即梦视频3.0pro生成)

(段落2-提示词修改版-可灵视频2.1生成)

鱼游树洞的视频中,海螺2.3生成的(短版提示词)和可灵生成的视频效果都不错。

武打的视频中,只有海螺生成的视频符合逻辑、有激烈打斗氛围。而即梦的追逐像朋友小跑,不符合场景和身份,还有角色直接腾空未借力,还没开打竹叶就落了的问题;可灵打斗比较燃,但是中途角色会变来变去。

当你将所有视频段落的短视频生成完成之后,就可以按照提示词给出的音效音乐进行配音和剪辑了。

小结

经过反推图片、反推视频的分析,我们发现:

1.使用Gemini的反推结果会更好;

2.反推视频需要生成视频验证,并且在验证中优化提示词;

3.验证并辅助提示词优化的AI工具中,海螺是个不错的选择;

4.无论怎样优化提示词,你都无法生成和参考视频一模一样的视频;

5.在“优化提示词-重新生成提示词”的循环中,自己直接改剧情会更省时省事。

制作一个几十秒及以上的AI视频其实是一个比较漫长的过程。

为了提效,我们需要收集、管理及熟练掌握提示词模板,需要建立提示词库、熟悉各大视频创作工具的特点,有时候会卡在5s的视频段落中出不去。

所以,无须执着于生成和大佬一模一样的爆款视频。抓住生产流程和提示词结构的“形”,注入自己独特剧情之“魂”,才是我们要走的路。

好了,今天的分享就到这里了。若你对反推提示词和验证提示词的生图工具也有体验和感悟,欢迎在评论区分享和讨论,也欢迎大家入群交流哦~