AIGC怎么检测论文?中文检测比英文难搞多了

说真的,现在论文查重这事儿变复杂了。你可能还记得几年前用Turnitin查查重就能搞定,但现在不一样了——AI生成的内容铺天盖地,老师们头疼得很。

技术手段其实没你想得那么玄乎

市面上检测AI生成内容的工具,原理基本都差不多。它们会分析文本的"困惑度"(Perplexity)和"突发性"(Burstiness)。

听起来挺专业?其实简单说就是——AI写东西太规矩了。

人写文章的时候,有时候句子长,有时候短。可能突然冒出个口语化的表达,也可能为了强调某个观点重复几次。但AI不会,它生成的文本就像流水线产品,每句话的复杂程度都差不多,读起来"太顺"了。

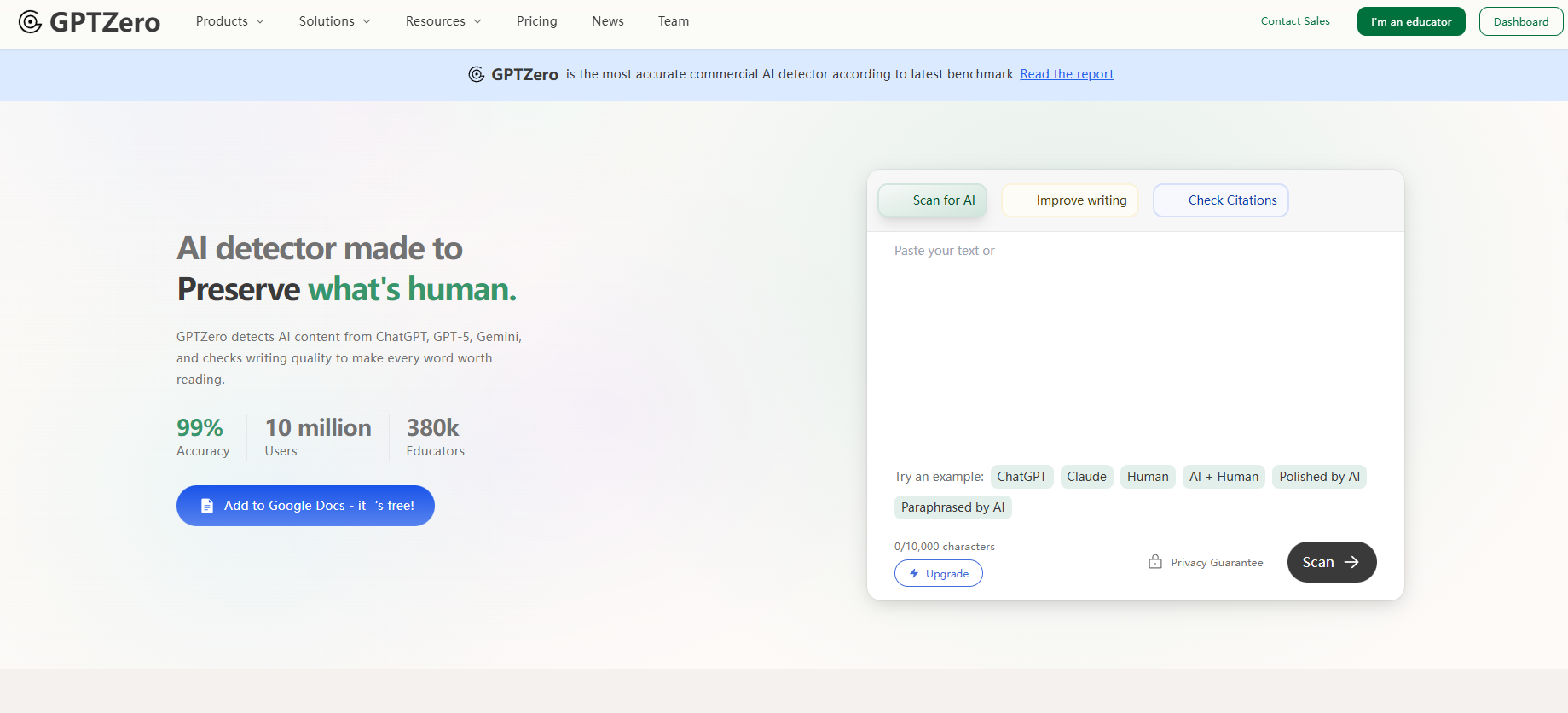

GPTZero、Originality.ai这些工具就是抓住这个特点。拿ChatGPT生成的学术文本去检测,准确率能到70%-80%。

当然,如果学生够聪明,知道怎么"后处理"这些内容,准确率就会下降。

别光靠工具,人眼有时候更管用

AI检测软件能识别语言模式,但很难判断内容的"灵魂"。

你自己写论文的时候,肯定会有些磕磕绊绊的思考过程,会有些不太成熟但很真诚的观点。AI生成的东西呢?太圆滑了,什么都说了,但好像又什么都没说。

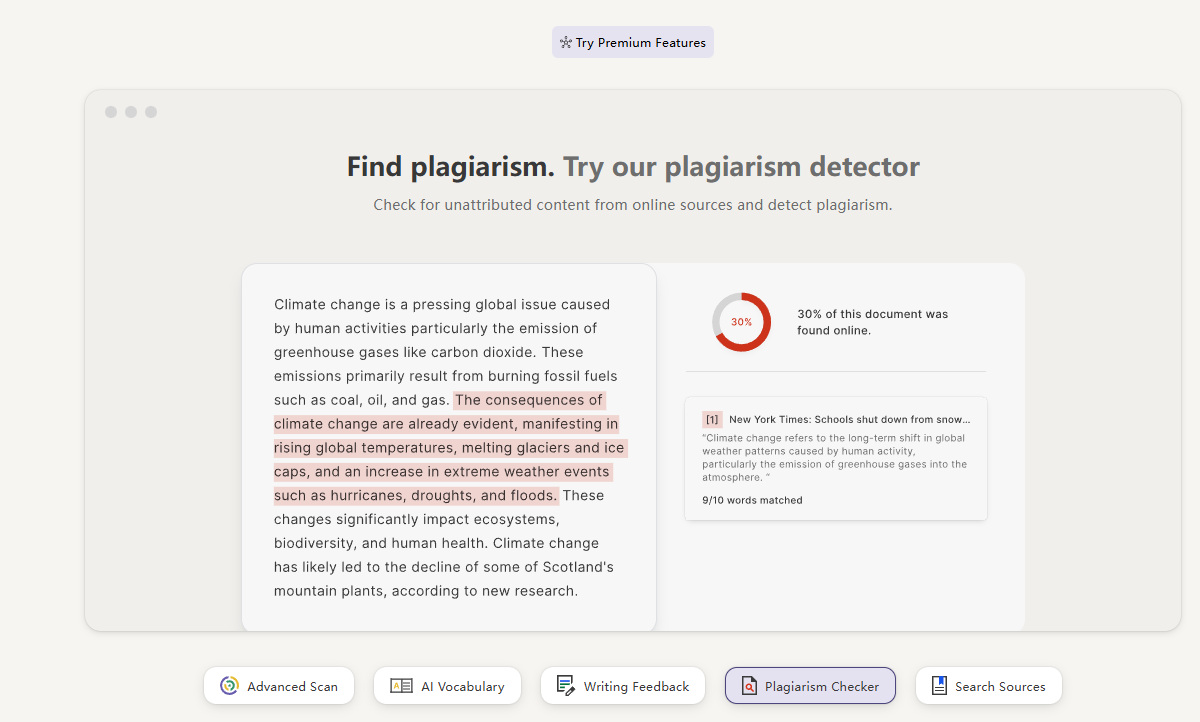

比如一篇文章用了检测工具显示AI生成概率只有30%,但整篇论文引用格式完美,逻辑严密得像教科书,但就是没有任何个人思考的痕迹。

所以我的建议是,检测工具+人工审查双管齐下。特别要注意那些突然画风一变的段落,或者引用文献的方式前后不一致的地方。

学生如果真是自己写的,哪怕水平一般,至少"毛病"会很统一。

中文检测比英文难搞多了

这是个很现实的问题。现在主流的AI检测工具,基本都是针对英文训练的。中文呢?数据量少,语言特征又复杂。我试过用国内几个号称能检测中文AI写作的平台,效果真的参差不齐。

中文的语义理解难度本来就高,再加上各种成语、俗语、网络用语混在一起,AI检测器很容易"抓瞎"。

你用文言文写一段,它可能判定是AI生成的;你让ChatGPT写一段大白话,它反而觉得是人写的。

不过话说回来,如果你的论文是中文的,可以尝试知网的"AI辅助写作检测"功能,或者用维普的相关工具。虽然不能说100%准确,但至少比那些国外工具靠谱一些。

AIGC检测这个领域正在进入军备竞赛阶段。AI生成工具在进化,检测工具也在升级。但我个人觉得,纯技术手段可能永远无法彻底解决这个问题。

因为语言本身就是人类思维的产物,当AI足够先进时,它生成的内容和人类写的内容之间的边界会越来越模糊。到那时候,你还能说哪些是"纯人类创作"吗?

就眼下来说,如果你需要检测论文是不是AI生成的,我的建议很实际:用工具筛查一遍,然后自己认真读一遍,相信你的直觉。