ai作图是拼接吗?怎么拼?

说实话,当我第一次看到AI生成的图片时,我也有点懵。这玩意儿到底是怎么做出来的?是从网上找一堆图片然后拼在一起吗?后来深入了解才发现,事情远没有那么简单。

别被"拼接"这个词误导了

你可能听过有人说AI作图就是"拼图游戏",把网上的素材东拼西凑弄在一起。但这种说法真的不准确。

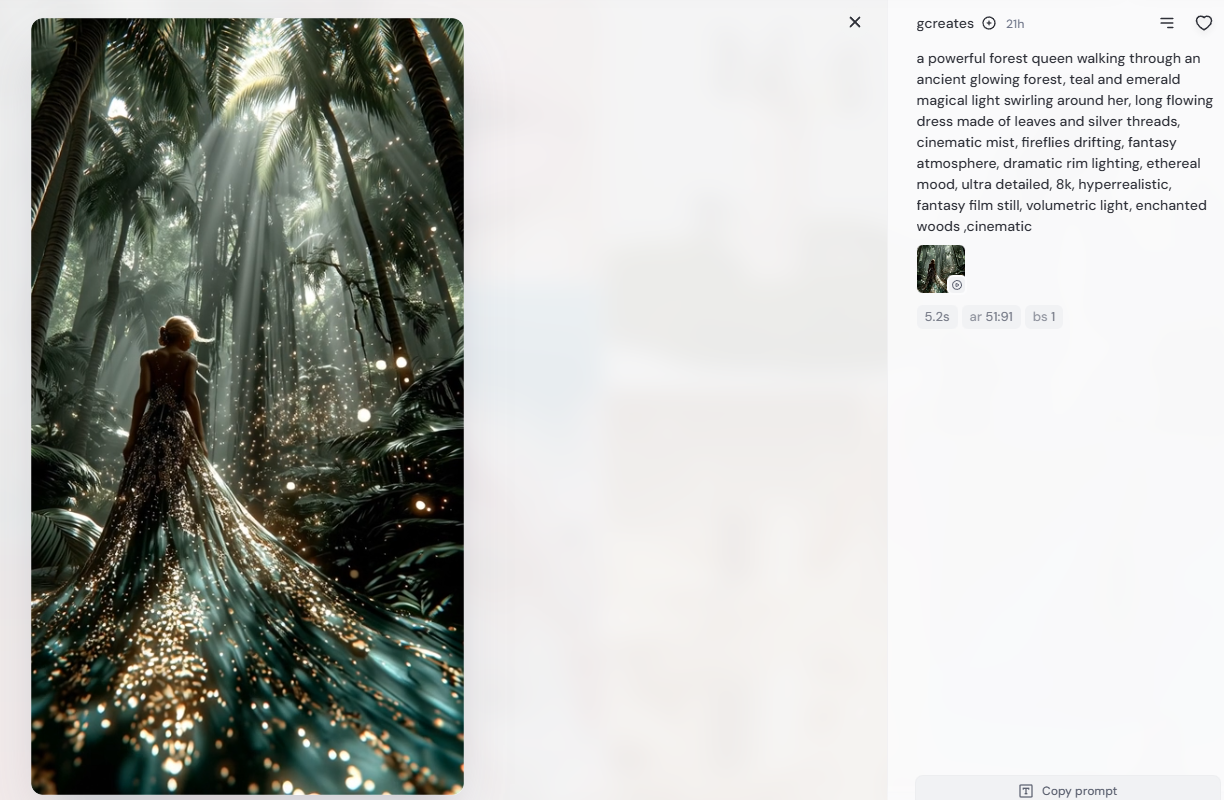

如果AI真的是简单拼接,那你让它画一只"穿着西装骑独角兽的猫",它怎么可能找到这么奇怪的现成图片?

实际上,AI生成图像的过程更像是在"理解"和"创造"。

它在训练的时候确实看过海量的图片,但它学到的不是图片本身,而是图片背后的特征、规律和概念。

就好比你小时候学画画,老师让你画苹果,你观察了很多苹果之后,脑子里形成了"苹果"这个概念——圆的、红色的、有果梗。下次画的时候,你不是照着某个特定的苹果描,而是根据你理解的"苹果"特征重新画一个出来。

从噪点到成品的神奇旅程

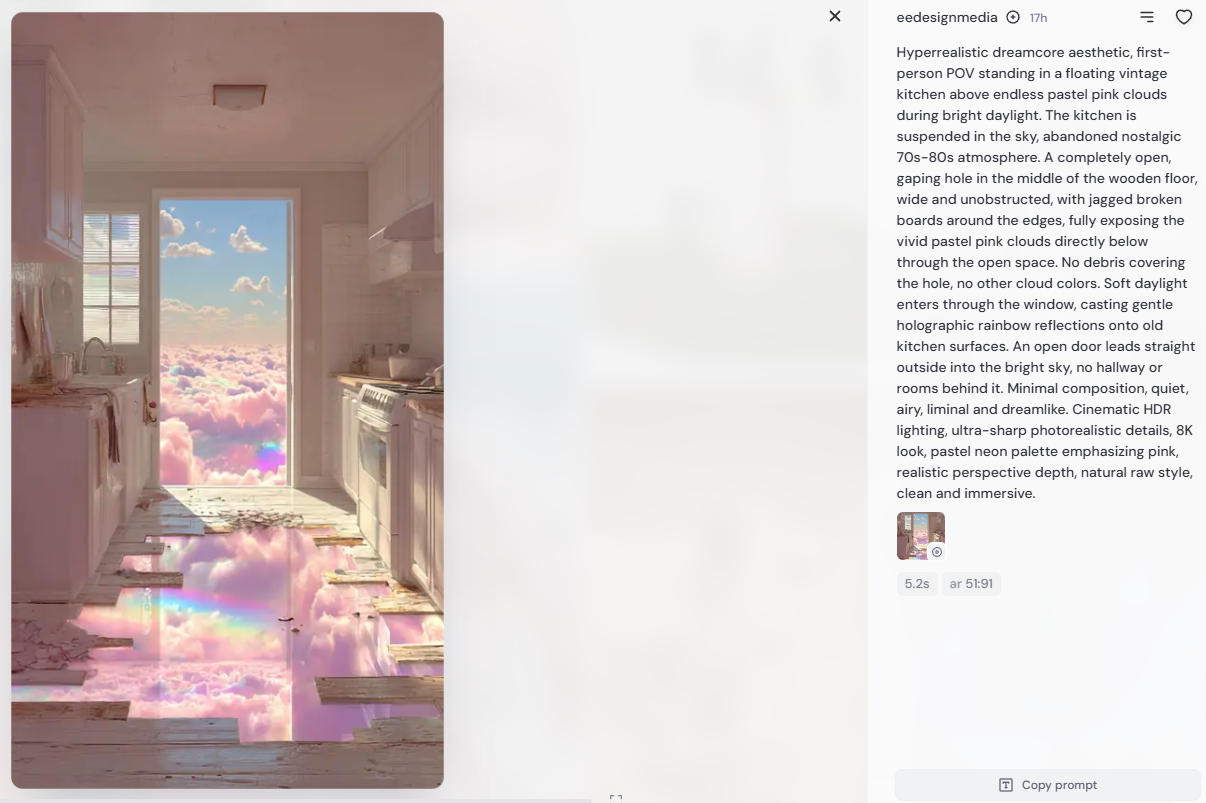

现在主流的AI绘画技术,比如Stable Diffusion、Midjourney这些,用的都是扩散模型。这个过程说起来有点反直觉。

AI拿到你的文字描述后,会先在画布上撒一堆随机的噪点,看起来就像电视机没信号时的雪花屏。然后它开始一步步"去噪",慢慢把这些噪点整理成有意义的图像。

这个过程中,AI会不断参考它学过的知识——什么是"猫"的特征,什么是"西装"的样子,什么是"独角兽"的形态,然后把这些元素融合到画面里。

整个过程可能需要几十次迭代。每一步都在调整像素,让画面越来越清晰,越来越符合你的描述。

这不是在拼接现有的图片,而是在"无中生有"地创造新的视觉内容。

所谓的"拼接"其实是特征重组

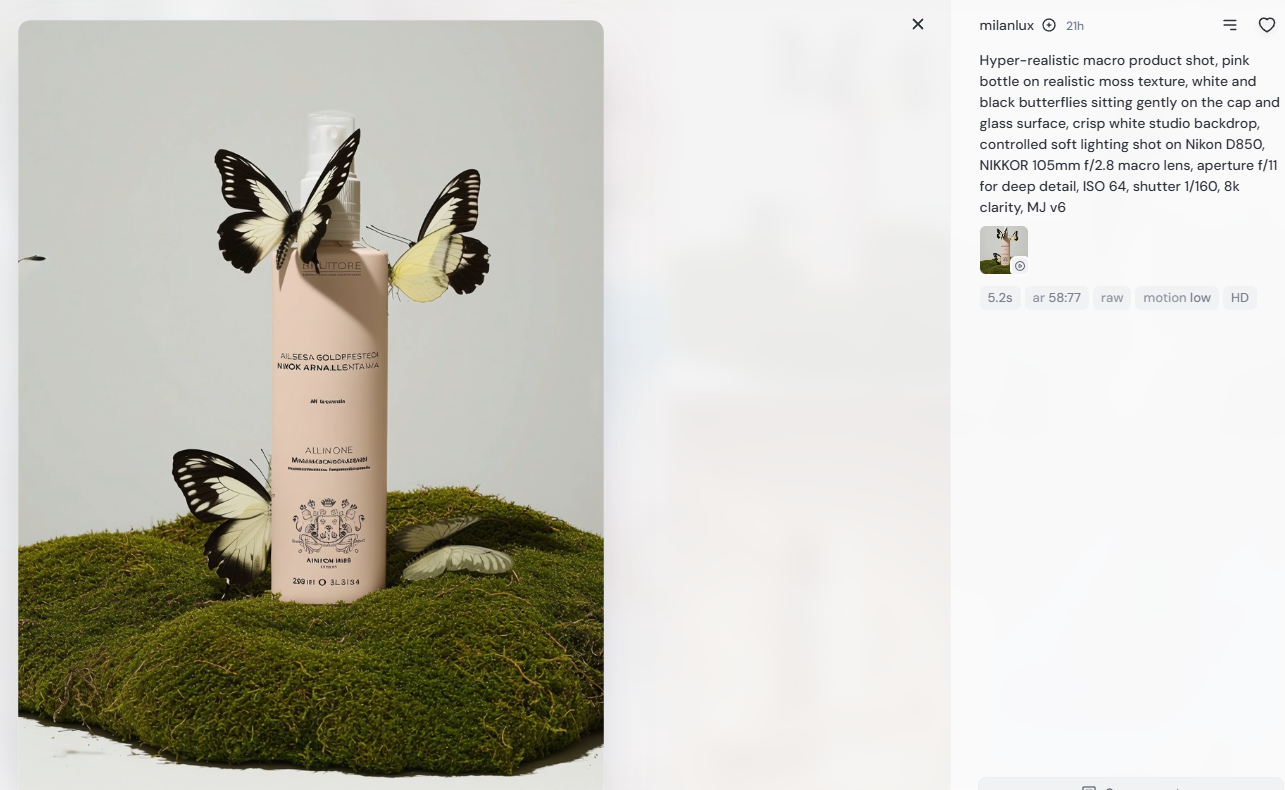

如果非要说AI作图有"拼接"的成分,那这个"拼"也不是物理意义上的剪切粘贴,而是特征层面的重组。

假设AI在训练时见过梵高的《星月夜》,也见过现代都市的夜景照片。当你让它生成"梵高风格的上海夜景"时,它不会从这两张图里各切一块拼起来,而是提取《星月夜》的笔触特征、色彩风格,再结合上海的建筑特征、灯光分布,然后在像素级别上重新生成一张全新的图像。

这种"拼"更像是DNA的重组,而不是乐高积木的组装。最终生成的图像,你很难说它的某个部分来自哪张训练图片,因为所有的像素都是AI重新计算出来的。

为什么有时候能认出"原型"

不过你可能也注意到了,有些AI生成的图片看起来确实很眼熟,甚至能认出某些知名作品的影子。这是怎么回事?

这主要跟训练数据的分布有关。如果某个视觉元素在训练集里出现频率特别高,AI就会对它形成很强的"记忆"。

比如蒙娜丽莎的微笑、埃菲尔铁塔的轮廓,这些元素太经典了,出现次数太多,AI就会把它们当成某种"标准模板"。

但即便如此,AI也很少会完整复制一张图。更多的情况是,它会把这些经典元素融入到新的场景里,或者用不同的风格重新演绎。

除非你故意用非常具体的提示词去复现某张特定图片,否则AI生成的内容基本都是独特的。

这种方式有什么问题吗

当然有争议!版权问题是最大的一个。

虽然AI不是直接拼接图片,但它确实是从海量的图像数据中学习的,而这些数据很多没有经过原作者授权。有艺术家觉得这是变相的"偷窃",因为AI的能力是建立在他们作品的基础上的。

另一个问题是,AI可能会放大训练数据里的偏见和刻板印象。

如果训练集里某类图像过多或过少,生成的结果就会失衡。比如早期的一些AI模型,生成"护士"大多是女性,生成"CEO"大多是白人男性,这就反映了数据集的偏见。

不过话说回来,技术本身是中性的。关键在于我们怎么用它,怎么规范它。现在已经有很多团队在研究更公平的训练方法,更透明的数据来源,以及更合理的版权机制。

AI作图不是简单的拼图游戏,而是一个复杂的学习和创造过程。它确实站在前人的肩膀上,但最终生成的是全新的东西。