aigc检测英文吗?英文确实是主战场

你现在打开那些AIGC检测工具,会发现大部分都是英文界面,而且检测的内容也主要针对英文文本。这不是巧合,背后其实有很多原因。

英文确实是主战场

说实话,AIGC检测技术最早就是从英文内容开始的。OpenAI、GPT系列模型最初训练的主要语料就是英文,所以检测工具也优先针对英文开发。

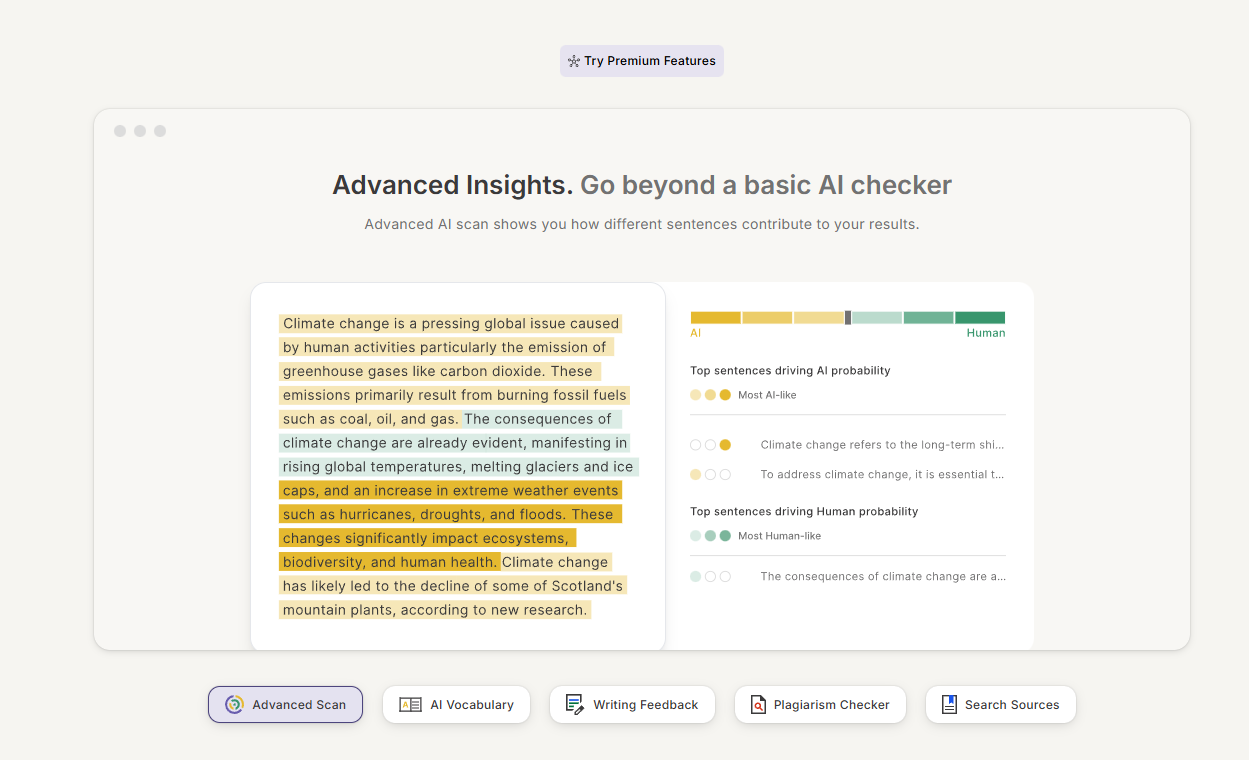

Turnitin、GPTZero、Originality.AI这些知名检测平台,英文检测的准确率能达到90%以上,但换成中文可能就只有60%-70%了,这种差距不是一点点。

我之前测试过,同一段内容用ChatGPT生成英文版和中文版,英文的那段被检测出来的概率明显更高。为啥?

因为英文AI写作有更明显的特征模式——比如句式结构过于工整、用词频率异常、逻辑连接词使用过度等等。

而且国外学术界和内容平台对AI生成内容的警惕性更高,需求量大,自然推动了英文检测技术的快速发展。你看美国那些大学,早就把AI检测工具整合进作业提交系统了。

中文检测也在追赶

不过别以为中文就没人管。国内这两年AIGC检测工具也冒出来不少,像百度的AI内容检测、腾讯的智能创作检测,还有一些专门针对学术论文的查重系统都加入了AI检测功能。

但坦白讲,效果还是参差不齐。中文的语言结构比英文复杂太多了,同样的意思可以有无数种表达方式。AI生成的中文内容更容易"藏"起来,检测起来难度也更大。

我自己试过用DeepSeek和文心一言生成中文内容,然后丢到检测工具里,有时候居然显示"人类创作概率80%"。

这就很微妙了,到底是工具不行,还是中文AI写得太像人了?

检测原理其实差不多

不管英文还是中文,AIGC检测的底层逻辑都是类似的。主要看几个维度:

语言模式的规律性

AI写东西往往太"顺"了,缺少人类写作时的那种犹豫和调整。比如人类可能会写个半句然后换个说法,但AI通常一气呵成,这种流畅度反而成了破绽。

词汇和句式的多样性

人类写作会下意识地变换句式,用词也更随性。AI虽然也会变,但那种变化有种说不出的"机械感"——就像你能感觉到它在刻意追求多样化一样。

困惑度(Perplexity)

这个指标衡量的是模型对文本的"意外程度"。人类写作往往更出其不意,而AI生成的内容对AI本身来说太好预测了,困惑度就会偏低。

这些原理对英文和中文都适用,只不过在中文上的判断阈值需要重新调整

AIGC检测英文的技术确实更成熟,但这不代表其他语言就完全检测不了。技术在进步,中文检测工具也在快速迭代。