Mistral AI发布第二代开源编码模型:Devstral2性能超群,采用差异化许可策略

刚刚,「欧洲的DeepSeek」Mistral AI正式推出其第二代开源编码模型Devstral 2。此次发布的核心亮点是旗舰模型在性能上实现突破,同时该公司采用了针对不同规模模型的差异化许可策略。

该系列开源模型包含两个尺寸:Devstral 2(123B)和Devstral Small 2(24B)。用户目前也可通过官方的API免费使用它们。

此外,Mistral AI还发布了自家的原生CLI:Mistral Vibe。

Mistral AI的进击速度令人咋舌。仅仅一周前,他们才发布Mistral 3系列模型,被视为欧洲正式以此跻身AI前沿竞争的序幕。仅仅过了7天,Devstral 2系列与Mistral Vibe便紧随其后问世,这种高频的发布节奏,似乎正在印证人们对欧洲AI崛起的判断。

考虑到Mistral近期在欧洲的大幅扩张,以及图灵奖得主Yann LeCun回到欧洲创业的消息,欧洲大陆这片AI热土的未来风景,或许值得我们投入更多期待。

亮点汇总:

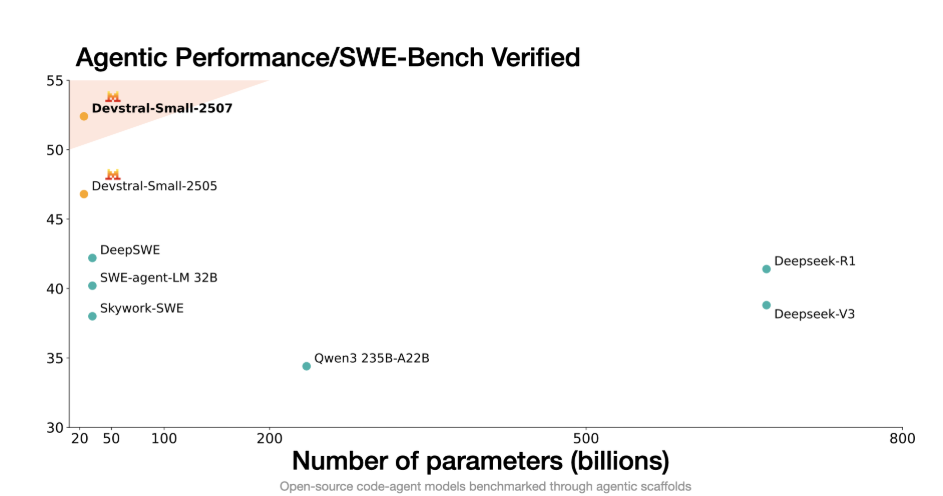

针对代码智能体(Agent)的SOTA开放模型,参数量仅为竞争对手的一小部分,并在SWE-bench Verified上达到了72.2%的高分。在实际任务中,其成本效率比Claude Sonnet高出达7倍。

Mistral Vibe CLI:一款原生、开源的终端智能体,可自主解决软件工程任务。

Devstral Small 2:24B参数模型,可通过API使用,也可在消费级硬件上本地部署。

兼容本地(On-prem)部署和自定义微调。

下面来具体看看Mistral AI今天新发布的模型和工具。

Devstral:下一代SOTA编程模型

模型地址:https://huggingface.co/collections/mistralai/devstral-2

Devstral 2是一个123B参数的密集Transformer模型,支持256K上下文窗口。它在SWE-bench Verified上取得了72.2%的成绩,「确立了其作为最佳开放权重模型之一的地位,同时保持了极高的成本效益。」

体量更轻的Devstral Small 2在SWE-bench Verified上得分为68.0%,能与大其五倍的模型比肩,同时还具备在消费级硬件上本地运行的独特优势。

Mistral官方指出:「Devstral 2(123B)和Devstral Small 2(24B)分别比DeepSeek V3.2小5倍和28倍,比Kimi K2小8倍和41倍。这证明了紧凑型模型可以匹敌甚至超越更大型竞争对手的性能。」

在相同测试框架(由Al Hands Al"提供的OpenHands)下评估时,Devstral的表现远超Deepseek-V3-0324和Qwen3 232B-A22B等更大规模的模型。

Devstral 2支持探索代码库并在多个文件中编排变更,同时保持架构级的上下文理解。它能追踪框架依赖关系、检测故障并尝试修正重试——从而解决错误修复和遗留系统现代化等挑战。

此外,该模型支持微调,允许企业针对特定编程语言或大型企业代码库进行深度优化。

Mistral通过独立标注提供商的人工评估,对比了Devstral 2与DeepSeek V3.2和Claude Sonnet 4.5,任务通过Cline进行脚手架式编排。

根据发布的结果,Devstral 2相对于DeepSeek V3.2有明显优势,胜率为42.8%,败率为28.6%。然而,Claude Sonnet 4.5仍然更受青睐,表明其与闭源模型之间仍存在差距。