千问和豆包哪个好?以教学方面为例

千问和豆包哪个好?最近的资讯,12月3日阿里千问App接入了号称“阿里最强学习大模型”的Qwen3-Learning,又是一个专为教育场景设计的更新。据官方数据,千问App公测首周下载量即突破1000万,创下全球AI应用增长纪录。除了各种PR文之外,实际使用效果如何?对比豆包呢?本文从题目答疑、作业批改、作文批改三个核心场景分别测试,看看真实的水平到哪里。

PK1:题目答疑

对大模型来说,这个测试应该是最简单的。

两个的模型的解题答疑效果还是挺不错的,能直接把这道题的解答过程还原出来。模型背后的训练使用了题目数据,或者是直接调用了知识库查询这道题目。

但这里面千问的解答过程更有意思一些,题目是一个图形堆叠的题目,在解析题目时,千问尝试通过可视化的视图,来解析立方体的堆叠关系。

PK2:作业批改

作业批改的实现逻辑挺复杂的,核心步骤:题目识别>正确答案>识别手写内容>比对答案。

首先测试选择题、填空题这类客观题目,批改还可以,无论是豆包,还是千问,都能正确批改出来。

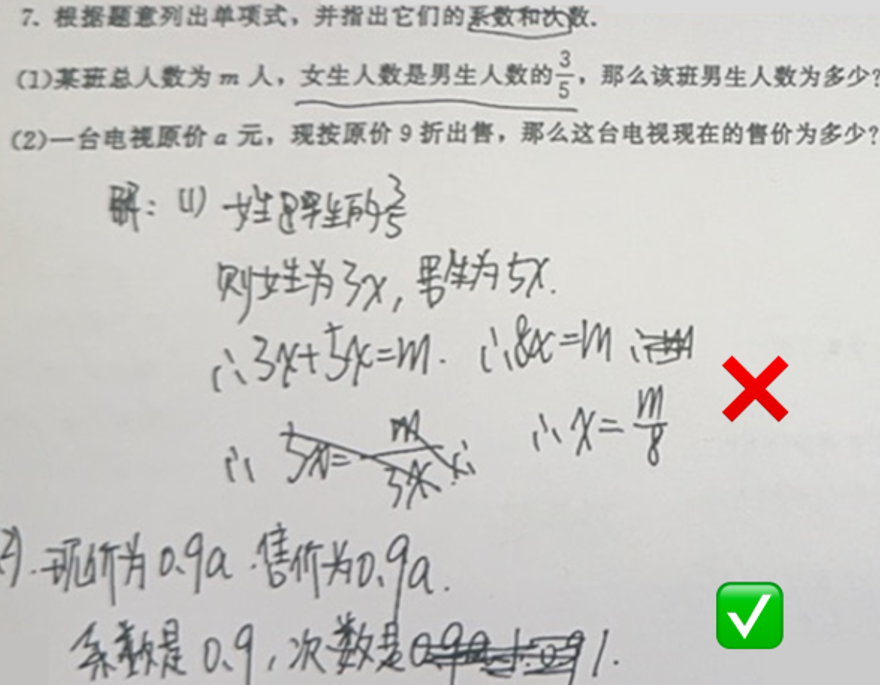

试试解答题(测试并没有使用复杂的几何体。),这种题目特别容易翻车,因为学生的书写笔记潦草,而且解答过程长,也可能有多种解法。

这道题很巧妙,明面上是算每个小问的题目,但题干上要求是解了每个巧题之后,指出它的系数和次数。

实测下来,这道题豆包、千问都翻车了...

○豆包:有一小题批错误了,对手写答案的识别有误

○千问:不单是批改的结果错了,批改解释也是顾左右而言它,完全说不到点上

PK3:作文批改

作文最难的不是把句子或者词汇拿出来讲解,而是能符合课标要求,给出准确的分数。

这里分别拿两篇文章来去测试,是一类文,一篇是四类文,看一下他们的评分。目前用AI字接去批改学生的作文都很难完全拟合老师的批改。一方面是批改它有主观性。另外一方面的话,不同模型对作文的解读还是有偏差的,没有办法完全追求一致。

测试的1文章,教师的评分分数47分(以50分满分制),定档一类文。豆包评分偏高,千问评分偏低。

测试的2文章,教师的评分分数24分(以50分满分制),定档四类文。豆包评分偏高,千问评分偏低.

两款产品在复杂学习任务的处理上,仍有显著短板:

1、作业批改时,二者均未能精准捕捉解答题的核心要求,暴露了对题干深层逻辑理解与手写内容识别的短板;

2、作文批改时,无论是豆包的评分偏高还是千问的评分偏低,都反映出AI兼顾主观评判与客观标准上,与人工批改仍有差距。

当前AI学习助手能胜任基础的学习辅助工作,但在复杂知识拆解、主观内容评判等高阶场景中,仍需持续优化模型的理解能力与适配性。如何进一步缩小与人工教学的差距,真正成长为学习者可信赖的“靠谱学习科代表”,仍是各类AI学习工具未来需要攻克的核心课题。