WAN 2.6发布:克隆级致性+首创商业API

今天,阿里新一代的万相2.6系列模型正式发布,面向专业影视制作和图像创作场景进行了全面升级。

全新的万相2.6是国内首个支持角色扮演功能的视频模型,支持音画同步、多镜头生成及声音驱动等功能,是全球功能最全的视频生成模型!

先说重点,主要更新点在下列几个方面:

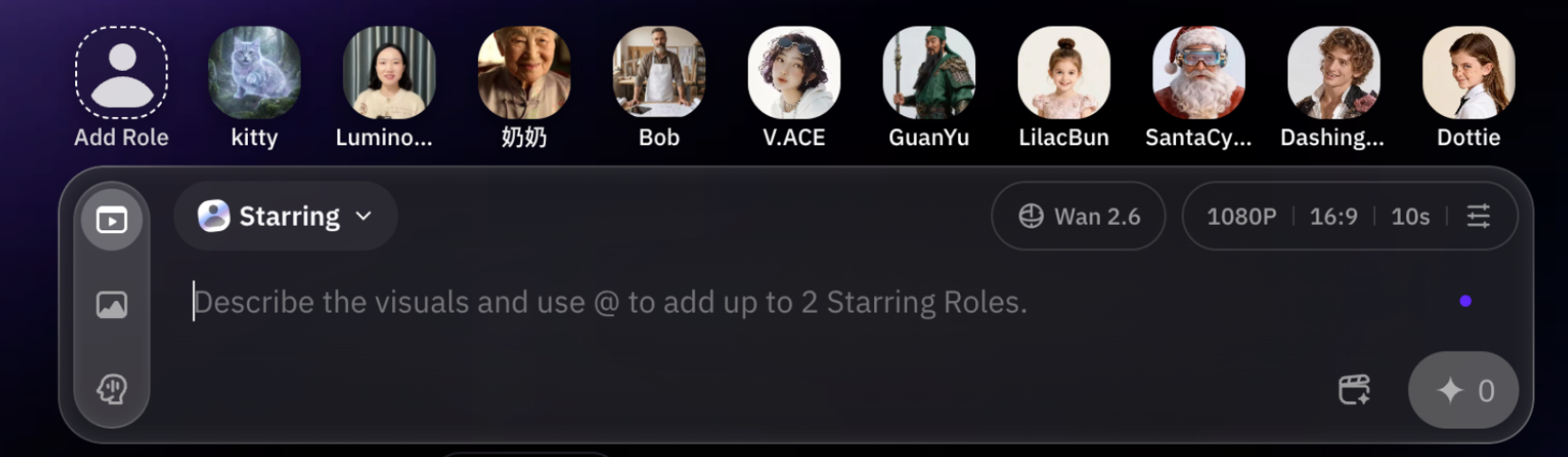

1.国内首个支持“角色扮演”功能,可以参考形象和人物音色,参考形象可以是人物、动物或者物体;

2.单人表现双人合框都可以尝试,人物音色也可以匹配;

3.可以多个镜头智能调度了,可以在一致性统一的基础上智能分镜;

4.视频时长扩展,最长可以15秒了,分辨率最高1080P,叙事更完整,画面也更丰富了。

现在可以将人物、动物、物体设定为角色,然后基于参考素材生成表演视频了。在此前的AI视频生成技术框架中,我们只能通过文本描述或单张图片引导模型生成视频内容,无法精确控制视频中的角色形象。万相2.6现在也引入了【角色扮演】能力,从根本上改变了这一创作逻辑。

设定元素为视频主角后,轻松调用,模型会基于参考素材生成连续的表演内容。镜头也是有智能调度的分镜,这个后面会提到。

此外,还有一个亮点,万相2.6不仅能够提取参考视频和素材中的视觉特征,还能同步捕捉声音特征,确保了角色生成视频后在形象与声音两个维度上的一致性。现在处理多人同框对话的复杂场景的时候,角色的口型动作与各自的语音内容都能精确地对应了。

使用起来很简单,在这里直接录制或上传自己录制的视频,然后通过 就可以调用了。

另外,视频中合成的声音也摆脱了明显的机械感,现在的节奏和情感表达都比较趋近于真实的人声了。

提示词:

Luminous_3524站在黑板前,小声发问:我14岁了,还没学会微积分,以后还能当数学家吗

AlbertEinstein盯着黑板看了两秒,又看了看你,认真点头:当然可以

AlbertEinstein指了指自己的头发,补一句:你看,我到现在也没学会梳头

场景:老教室,黑板,粉笔灰,爱因斯坦的头发在灯光下格外抢戏,整体轻松、荒诞、像一条冷笑话结尾

合拍包括了单人独立表演与双人同框合拍两种模式,并且可以基于参考视频中的IP形象进行视频生成,保持角色外观一致性,还可以同步参考输入视频中的声音特征,实现声画匹配,也同时支持通过提示词对视频内容、动作、场景进行精细化控制。

AI视频生成中的音频处理一直是技术难点。早期模型生成的视频都是默片,后续叠加了语音合成能力,也普遍存在口型与声音不匹配、多人场景音色乱套、人声质感机械麻木无感情纯念稿等问题。

万相2.6在声画同步方面基于之前也有针对性优化,上传音频,或者上传音频+图片,都可以得到视频情绪和口型音色都一致的视频了。

万相2.6模型新的智能分镜能力,允许我们可以通过简洁的文本描述传达叙事意图,模型自动规划镜头数量、景别切换及镜头时长分配。除了大全景或者太远的景人物可能会糊掉以外,在从特写到中全景的镜头方面的运镜效果是较为稳定的。

另外,模型能够在镜头切换过程中保持关键视觉信息的一致性。

面部细节、服饰细节、背景环境等在镜头切换之间能相对比较好地维持一致性,人物变形甚至换脸的问题就大大减少了。同时,在声画同步上的匹配精度也是能听出有优化了的,整体听起来很和谐。

比如下面这个,只需要一张图+提示词,一次性完成宠物电台搞笑视频。

在图生视频的基础上,两个角色的音色各有特色,细节到猫子离镜头远的时候声音会变小,镜头也会在发言对象说话的时候推进,整体还是比较丝滑的。