英伟达发布重磅AI计算平台Vera Rubin

2026-01-07 10:17

72

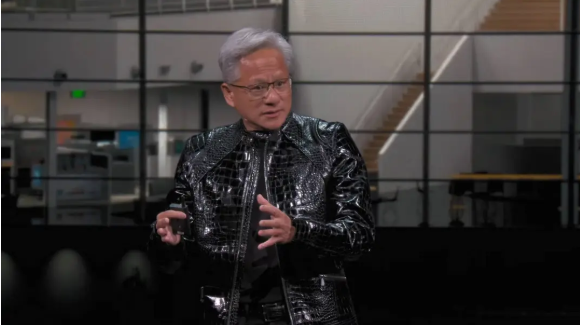

英伟达发布重磅AI计算平台Vera Rubin英伟达CEO黄仁勋发布了重磅AI计算平台Vera Rubin,打破五年未发消费级显卡的惯例。平台包含6款全新芯片,其中Rubin GPU推理算力达50 PFLOPS,是Blackwell的5倍。Vera Rubin NVL72系统性能全面提升,训练10万亿参数模型所需系统数量仅为前代1/4,成本降至1/10。

Vera Rubin计算平台登场,依旧是买越多省越多

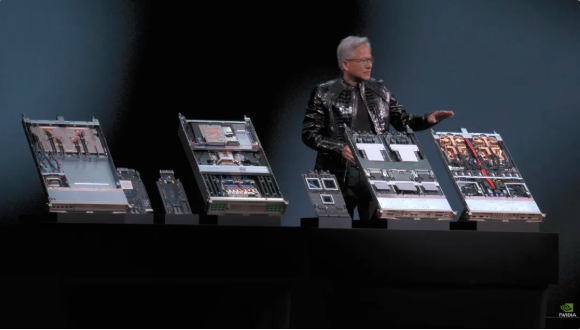

发布会期间,爱整活的老黄直接把一台2.5吨重的AI服务器机架搬上了舞台,也因此引出了本次发布会的重点:Vera Rubin计算平台,以发现暗物质的天文学家命名,目标只有一个:

加速AI训练的速度,让下一代模型提前到来。

通常来说,英伟达内部有个规矩:每代产品最多只改1-2颗芯片。但这次Vera Rubin打破了常规,一口气重新设计了6款芯片,并已经全面进入量产阶段。

究其原因,伴随着摩尔定律的放缓,传统性能提升方式已经跟不上AI模型每年10倍的增长速度,所以英伟达选择了「极致协同设计」——在所有芯片、整个平台各个层级上同时创新。

这6款芯片分别是:

1.Vera CPU:

-88个NVIDIA定制Olympus核心

-采用NVIDIA空间多线程技术,支持176个线程

-NVLink C2C带宽1.8 TB/s

-系统内存1.5 TB(为Grace的3倍)

-LPDDR5X带宽1.2 TB/s

-2270亿个晶体管

2.Rubin GPU:

-NVFP4推理算力50PFLOPS,是前代Blackwell的5倍

-拥有3360亿晶体管,比Blackwell晶体管数量增加了1.6倍

-搭载第三代Transformer引擎,能根据Transformer模型需求动态调整精度

3.ConnectX-9网卡:

-基于200G PAM4 SerDes的800 Gb/s以太网

-可编程RDMA与数据通路加速器

-通过CNSA与FIPS认证

-230亿个晶体管

4.BlueField-4 DPU:

-专为新一代AI存储平台而构建的端到端的引擎

-面向SmartNIC与存储处理器的800G Gb/s DPU

-搭配ConnectX-9的64核Grace CPU

-1260亿个晶体管

5.NVLink-6交换芯片:

-连接18个计算节点,支持最多72个Rubin GPU像一个整体协同运行

-在NVLink 6架构下,每个GPU可获得3.6 TB每秒的all-to-all通信带宽

-采用400G SerDes,支持In-Network SHARP Collectives,可在交换网络内部完成集合通信操作

6.Spectrum-6光以太网交换芯片

-512通道,每通道200Gbps,实现更高速数据传输

-集成台积电COOP工艺的硅光子技术

-配备共封装光学接口(copackaged optics)

-3520亿个晶体管

通过6款芯片的深度整合,Vera Rubin NVL72系统性能比上一代Blackwell实现了全方位的提升。

在NVFP4推理任务中,该芯片达到了3.6 EFLOPS的惊人算力,相比上一代Blackwell架构提升了5倍。在NVFP4训练方面,性能达到2.5 EFLOPS,实现3.5倍的性能提升。

存储容量方面,NVL72配备了54TB的LPDDR5X内存,是前代产品的3倍。HBM(高带宽内存)容量达到20.7TB,提升1.5倍。在带宽性能上,HBM4带宽达到1.6 PB/s,提升2.8倍;Scale-Up带宽更是高达260 TB/s,实现了2倍增长。

尽管性能提升如此巨大,晶体管数量只增加了1.7倍,达到220万亿个,展现了半导体制造技术上的创新能力。

在AI圈里时间就是金钱,一个关键数据是,训练一个10万亿参数模型,Rubin只需Blackwell系统数量的1/4,生成一个Token的成本约为Blackwell的1/10。

0

好文章,需要你的鼓励