阿里Owen团队开源多模态检索模型支持30余种语言

2026-01-09 11:44

159

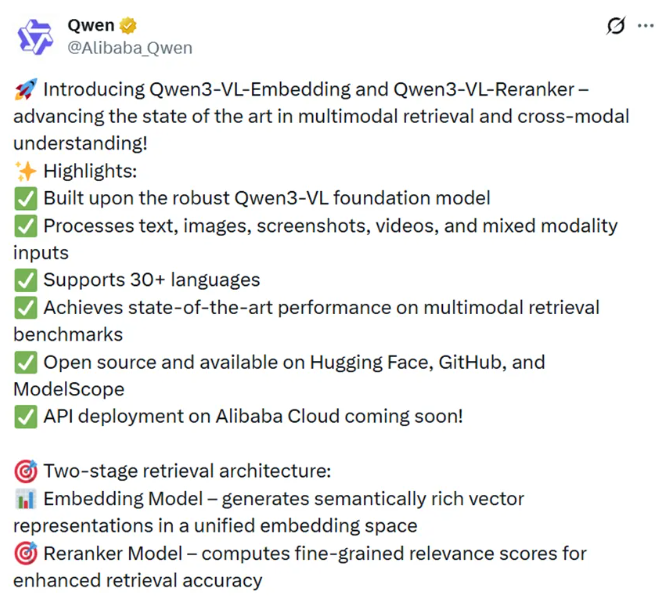

今天凌晨,阿里巴巴通义千问开源了两个重磅模型Qwen3-VL-Embedding与Qwen3-VL-Reranker,刷新多模态检索与跨模态理解业界标杆。

这两款模型基于强大的Qwen3-VL开发而成,支持文本、图像、截图、视频及混合模态输入,覆盖30+种语言,在多模态检索基准测试中斩获顶尖性能。

同时采用两阶段检索架构,嵌入模型生成语义丰富的统一向量表示,重排序模型通过细粒度相关性评分提升检索准确率,高效适配图文检索、视频搜索、多模态RAG等多元场景。

之前阿里通义千问在2025年6月开源的文本类嵌入和重排模型就挺火的,好多开发者都在用,不管是多语言检索还是聚类分类都能打。而最新开源的两个相当于强化版本,功能更猛了。

首先是多模态通吃这点太香了,文本图像截图视频不管是单独输入还是混着来,都能无缝处理。

像平时做图文检索、视频和文字匹配,甚至视觉问答和内容聚类,不用再换好几个工具来回折腾,而且效果都是行业里顶尖的水平,用着特别省心。

然后是统一的向量表示,这个得简单说下,Embedding模型就像个翻译官,能把文字和图片这些不一样的信息,都转换成同一种语言也就是向量,放在一个统一的空间里。

这样一来,想找它们之间的关联就容易多了,比如用文字找图片、用图片找视频,效率直接拉满。

还有重排序模型的配合,光有初步检索不够,精准度才是关键。

根据阿里的测试数据显示,Embedding模型的8B版本在MMEB-v2基准测试里直接超越了之前所有的开源模型和专有服务,尤其是在图像、视觉文档和视频检索这几个任务上,一直保持最优表现。

就算是纯文本多语言检索,虽然比同规模的纯文本模型稍差一点,但在同类多模态模型里已经很能打了。

Reranker模型更厉害,不管是2B还是8B版本,都比基础的嵌入模型和其他基准重排序模型表现好。

8B版本在大多数任务里都是顶尖水平,比如在MMEB-v2的视觉文档检索里拿到了86.3的高分,JinaVDR和ViDoRev3数据集上的表现也远超同类模型,把检索结果的精准度又提了一个档次。

对于这两个模型的实际使用,给大家分享个简单的使用思路,平时用的时候一般是两步走。

先用Embedding模型做初始召回,把可能相关的结果都捞出来,比如用几个文本查询,匹配相关的文本、图像或者图文混合内容,很快就能得到一批候选结果。

然后再把这些候选结果和查询一起交给Reranker模型,它会给出每个结果的相关分数,按照分数排序后,最精准的结果就排在前面了。

这俩模型其实只是阿里在多模态检索领域的第一步探索,相比纯文本模型,多模态检索还有很多可以优化的地方,比如模型成熟度、易用性和应用场景拓展。

不过这次开源已经是个很好的开始,相信随着社区的参与和迭代,后续会有更通用、更强大的多模态检索能力,不管是开发者还是普通用户,都能享受到和大厂一样的AI混合检索体验。

0

好文章,需要你的鼓励