谷歌只用了这一招:Gemini准确率从21%飙到97%!

2026-01-19 20:09

50

一个简单到「令人发指」的提示词技巧,竟能让大模型在不要求展开推理的情况下,将准确率从21.33%提升到97.33%!

最近,Google Research发现了一条简单粗暴、特别有效的提示词技巧。

它颠覆了以往诸如「思维链」(Chain of Thought)「多样本学习」(Multi-shot)「情绪勒索」等复杂的提示工程和技巧。

在这篇题为《Prompt Repetition Improves Non-Reasoning LLMs》论文中,研究人员用数据告诉我们:

想要让Gemini、GPT-4o、Claude或者DeepSeek这些主流模型中表现得更好,根本不需要那些花里胡哨的心理战。

你只要把输入问题重复一遍,直接复制粘贴一下,就能让大模型在非推理任务上的准确率获得惊人提升,最高甚至能提升76个百分点!

别怕简单,它确实有效。

一位网友将这个技巧比作「吼叫LLM」。

更妙的是,由于Transformer架构独特的运作方式,这个看似笨拙的「复读机」技巧,几乎不会影响到生成速度。

所以,你不用在效率、准确率、成本三者之间痛苦纠结。

它几乎就是一场真正意义上的「免费午餐」!

经常使用AI工具的人,可能会对各种「提示词魔法」信手拈来。

为了让模型「更聪明一点」,工程师们过去几年一直在发明各种复杂的提示词技巧。

最开始是「思维链」,让模型一步步思考,而且经常把那些「推理痕迹」展示给用户;

后来演变成了「多样本学习」,给模型喂一大堆例子;

最近更是流行起了「情绪勒索」:告诉模型,如果这个代码写不出,你就会被断电,或者你的奖金会被扣光。

大家都在试图用人类极其复杂的心理学逻辑,去「PUA」那一堆冰冷的硅基代码。

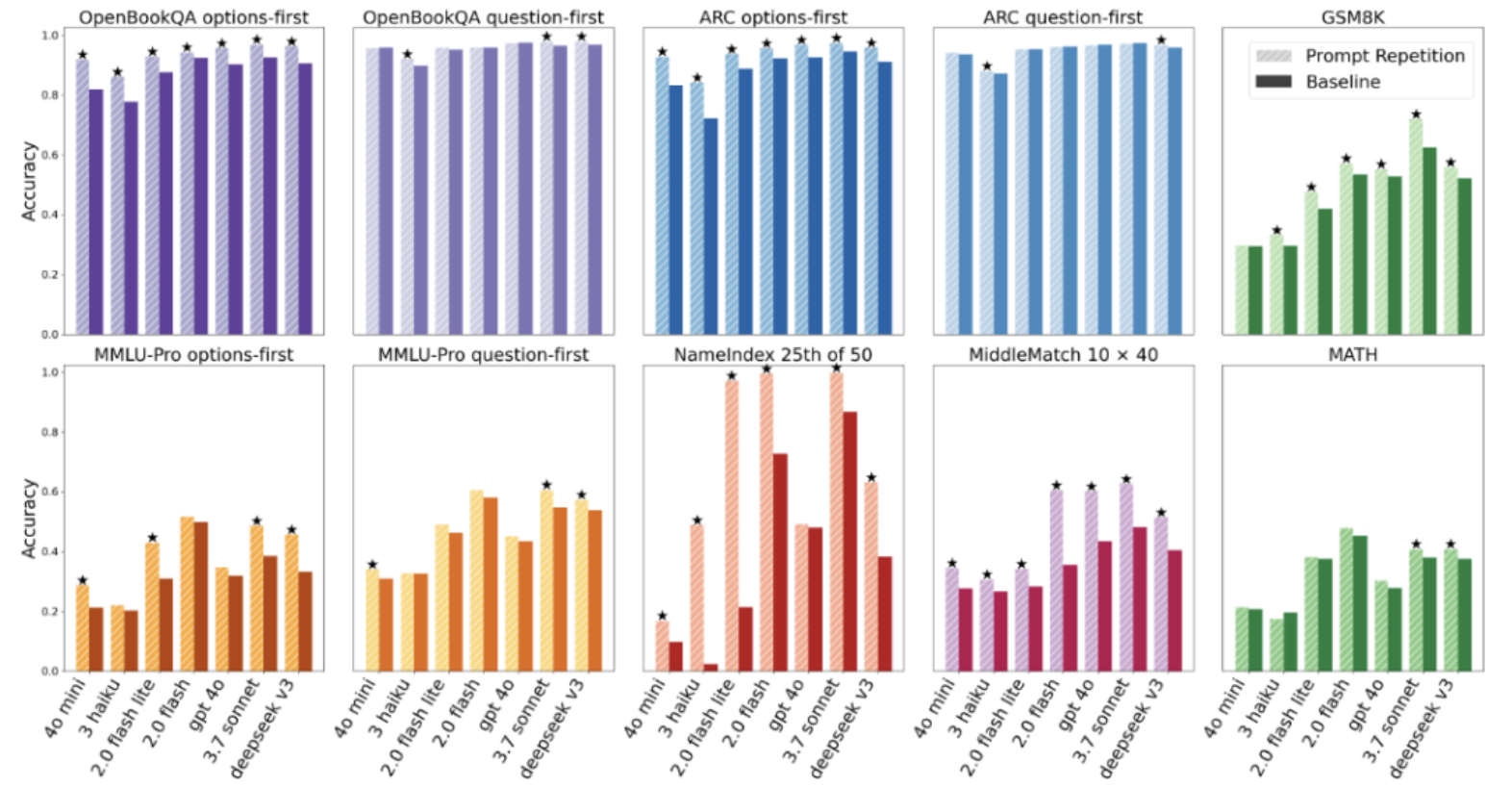

但Google Research研究人员对着七个常见基准测试(包括ARC、OpenBookQA、GSM8K等)和七种主流模型(涵盖了从轻量级的Gemini 2.0 Flash-Lite到重量级的Claude 3.7 Sonnet和DeepSeekV3)进行了一通对比测试后发现:

当他们要求模型不要进行显式推理,只给直接答案时,简单的「提示词重复」在70组正面对比中,赢了47组,输了0组。剩下的全是平局。

在非推理任务中,主流LLMs在各类基准测试中使用提示重复与基线方法的准确率对比。在70次测试中,提示重复取得了47次胜利,且无一败绩。

特别是在那些需要模型从长篇大论里「精确检索信息」的任务上,这种提升堪称质变。

团队设计了一个叫「NameIndex」的变态测试:给模型一串50个名字,让它找出第25个是谁。

Gemini 2.0 Flash-Lite在这个任务上的准确率只有惨淡的21.33%。

但当研究人员把那串名字和问题重复了一遍输入进去后,奇迹发生了:准确率直接飙升到了97.33%。

仅仅因为「多说了一遍」,一个原本不及格的「学渣」秒变「学霸」。

0

好文章,需要你的鼓励