字节开源 OmniTransfer:AI 视频迁移天花板,上传视频复刻全要素

2026-01-22 14:41

245

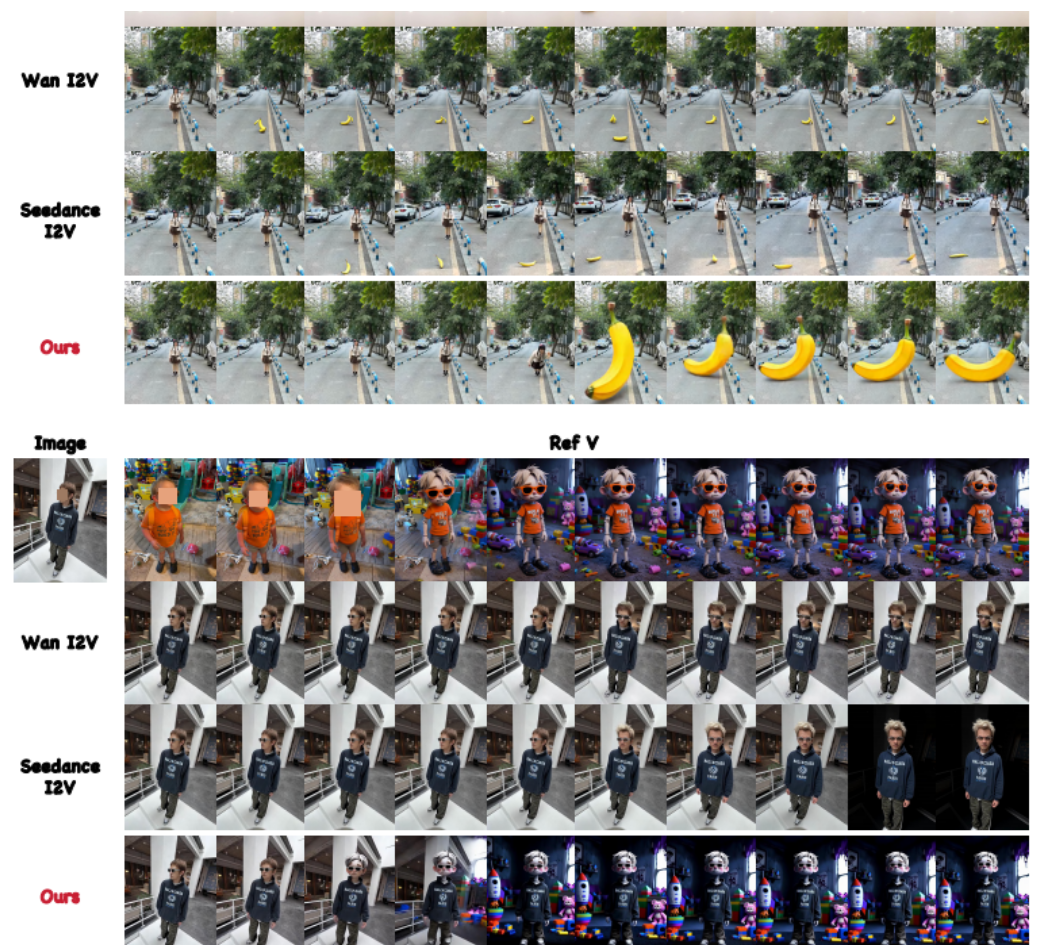

字节跳动智能创作实验室推出开源项目OmniTransfer,作为一款“全能型时空视频迁移框架”,它基于Wan2.1视频模型,无需复杂提示词,仅上传参考视频就能复刻特效、运镜、身份ID、风格、动作五大核心要素,还支持多要素组合迁移,彻底革新AI视频生成的“控制逻辑”。

一、核心定位与核心能力:从“单要素控制”到“全要素复刻”

OmniTransfer本质是“零样本、无提示词”的视频迁移工具,核心目标是解决传统AI视频工具“控制单一、依赖预处理(如Pose提取)、时间一致性差”的痛点,具体能力覆盖两大维度:

空间外观迁移:复刻参考视频的“身份ID”(人物360°特征,侧脸不崩坏)、“风格”(跨帧色调/质感,无闪烁割裂);

时间动态迁移:复刻“特效”(VFX光影交互,如火焰包裹人物)、“动作”(无Pose提取,遮挡场景也能精准模仿)、“运镜”(还原电影级镜头轨迹,如希区柯克变焦)。

更关键的是支持“组合迁移”,比如用A的身份ID+B的赛博朋克风格+C的舞蹈动作,无需拆分操作,框架自动实现语义对齐。

二、三大技术创新:解决视频迁移的核心难题

OmniTransfer的核心优势源于“解耦设计”,通过三个关键模块突破行业瓶颈:

1.任务感知位置偏置(TPB):让模型“懂任务、不跑偏”

核心作用:通过修改RoPE(旋转位置编码)偏移量,让模型根据任务类型灵活调用参考视频信息——动作/运镜迁移时,在“空间维度”加偏移保证动作连贯;风格/ID迁移时,在“时间维度”加偏移确保帧间一致;

解决痛点:避免传统模型处理长视频时“动作断裂、风格跳变”的问题,比如生成多镜头舞蹈视频时,左右画面人物动作能精准同步。

2.参考解耦因果学习(RCL):效率提升20%,拒绝“像素级复制”

核心设计:将“参考视频分支”与“目标生成分支”解耦,参考分支仅计算1次(设为t=0无噪声状态),单向向目标分支传输信息;

实际价值:推理时间从基准的180秒(81帧480p视频,8×A100环境)降至145秒,同时避免模型“偷懒复制参考视频像素”,实现真正的“迁移”而非“粘贴”。

3.多模态语义外挂(TMA):用Qwen-2.5-VL提升“指令理解”

突破点:抛弃传统T5文本编码器,接入多模态大模型Qwen-2.5-VL,通过“MetaQuery(元查询)”精准抓取参考视频关键信息(如特效迁移时只关注光影粒子,忽略无关人脸);

效果:中文指令理解准确率提升,比如“给人物加跟随式火焰特效”,模型能自动关联人物运动轨迹,让火焰产生真实光影交互,而非静态贴图。

三、当前状态与实用信息:开源进展与使用注意

开源进度:代码与数据集正进行内部审核,暂未开放git clone,可先Star GitHub仓库蹲守发布

适用场景:纯学术非商用,支持电商(商品换场景+特效)、短视频(网红同款动作/风格复刻)、影视预演(低成本复刻电影运镜);

硬件要求:需NVIDIA GPU(如A100),生成81帧480p视频约145秒,普通PC暂不支持轻量化运行;

版权说明:仅支持公共领域/AI生成素材,商用需联系团队获取授权。

四、行业意义:视频生成进入“Video-driven”新阶段

OmniTransfer的推出,标志着AI视频生成从“图片引导(Image-driven)”转向“视频引导(Video-driven)”——不再将视频视为“动起来的图片”,而是真正利用视频的“时空动态信息”。这种框架未来可能成为剪映等工具的底层技术,比如用户拍一段日常视频,上传《黑客帝国》参考视频,就能快速生成“自己躲子弹”的科幻片段,让专业视频创作彻底低门槛化。

0

好文章,需要你的鼓励