谷歌 Gemma-3n 发布:口袋里的端侧 AI,隐私与智能兼得

2026-02-13 05:16

63

谷歌正式推出Gemma 3家族专为手机优化的端侧大模型Gemma-3n。该模型以“物理隔离级隐私保护”“低功耗高性能”“原生多模态”为核心亮点,打破了端侧模型“阉割版”的固有偏见,标志着端侧AI革命的全面揭幕,让用户无需牺牲隐私即可享受智能服务。

一、核心亮点:重新定义端侧AI体验

1.轻量高效,续航友好

Gemma-3n体积仅4.9G,堪称“肌肉小钢炮”。谷歌官方数据显示,其在手机上长时间运行的电量消耗不足1%,彻底解决了传统端侧模型性能卡顿、发热严重的痛点,实现了轻量化与实用性的平衡。作为Gemma 3家族的一员,该模型依托家族10亿至270亿参数的多规格基础,针对性优化手机端运行效率,适配不同硬件条件。

2.物理隔离,隐私绝对安全

模型最核心的优势在于“数据不出手机”的物理隔离设计,让隐私保护从协议承诺升级为技术硬保障。所有数据处理均在本地完成,全程断网也能正常使用,实现0字节上传。典型应用案例包括离线医疗原型App,可本地分析昆虫咬伤照片并给出处理建议,避免了健康数据、家庭住址、财务报表等私密信息的泄露风险,让用户掌握数据主权。

3.原生多模态,感知能力全面

Gemma-3n并非单纯的文本交互模型,而是原生支持多模态能力。借助MobileNet-V5高性能编码器,它能听懂用户语气、看懂图片内容、自动生成提示词,可处理140多种语言。在无网络场景下,用户随手拍摄国外菜单,模型能瞬间完成翻译并解释背后的文化背景,这种“瞬时反馈+绝对私密”的体验,是云端AI无法替代的。

二、下载与使用:简单易操作

1.模型下载渠道

用户可通过ModelScope、Hugging Face平台获取模型权重,具体链接如下:

2.安装与导入步骤

解压后执行adb install-multiple*.apk完成安装;

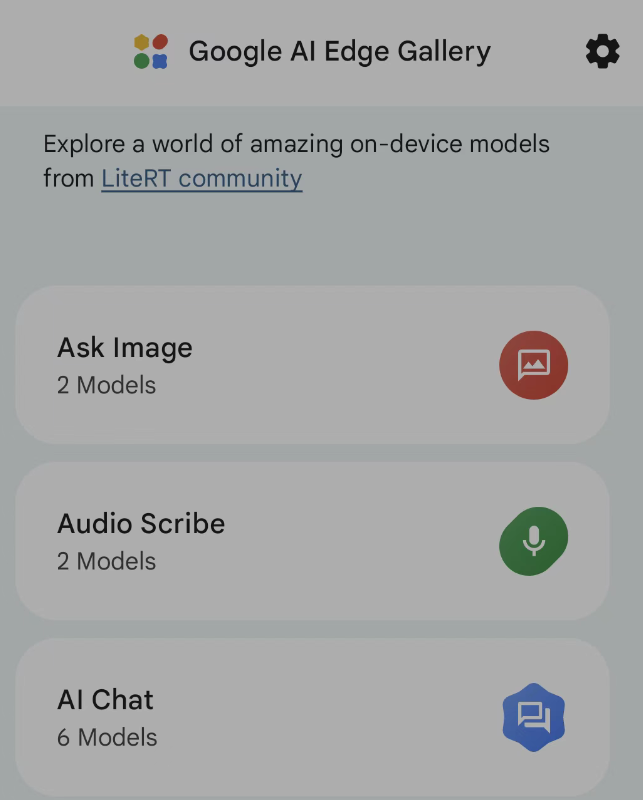

导入模型:打开Google AI Edge Gallery,选择“从本地文件导入模型”,配置默认参数(最大tokens1024、TopK64、TopP0.95等),支持图像、音频、移动动作等功能,兼容CPU与GPU加速;

性能表现:在CPU环境下,首token生成耗时5.18秒,预填充速度5.02 tokens/s,解码速度7.46 tokens/s,延迟39.23秒,满足日常交互需求。

三、行业意义:端侧AI挑战云端霸权

Gemma-3n的发布被视为端侧AI的“诺曼底登陆”,标志着“牺牲隐私换智能”时代的终结。它的出现打破了云端AI的长期垄断,让高性能智能服务走进口袋,随时随地可用。当能处理多语言、分析图谱、解读健康数据的AI大脑安稳存于手机闪存,且兼具低功耗与隐私安全时,端侧与云端的博弈进入新阶段,推动整个行业向“隐私优先、本地智能”的方向转型。

0

好文章,需要你的鼓励