国产编程神器 MiniMax M2.5 实测:10B 轻量模型,撑起跨端全栈开发

2026-02-13 05:20

419

2月12日,国产大模型厂商MiniMax正式推出新一代旗舰模型M2.5,以“极致轻量+极速推理”打破行业“参数越大越优”的固有认知。

该模型激活参数量仅10B,是第一梯队中参数最小的旗舰模型,却实现100 TPS的推理速度(约为Claude Opus的3倍),主打编程与智能体(Agentic)能力,尤其优化了移动端与跨端开发支持,为独立开发者与中小企业带来低成本、高效率的AI开发解决方案。

一、核心亮点:轻量与高性能的极致平衡

1.突破参数执念,轻量化设计降本增效

M2.5摒弃行业“堆参数”的内卷模式,以10B激活参数量实现旗舰级能力,彻底解决大模型“慢、贵”的核心痛点。其轻量化特性让开发者可轻松将模型部署于私有服务器,甚至仅需几千元成本的Mac Mini即可实现全天候运行,边际成本几乎可忽略,同时保障数据隐私安全。

2.极速推理+全栈适配,覆盖多开发场景

推理速度达100 TPS,远超同类模型,实现复杂逻辑秒级响应;

针对移动端开发短板专项优化,完美支持App、React Native、Flutter等跨端技术,可一次性适配Android、iOS、Web三端;

定位下一代数字化办公主力模型,编程能力比肩顶级旗舰,涵盖前端UI、后端逻辑、数据持久化等全流程开发需求。

二、实测验证:从零开发“春禧助手”App,全场景能力拉满

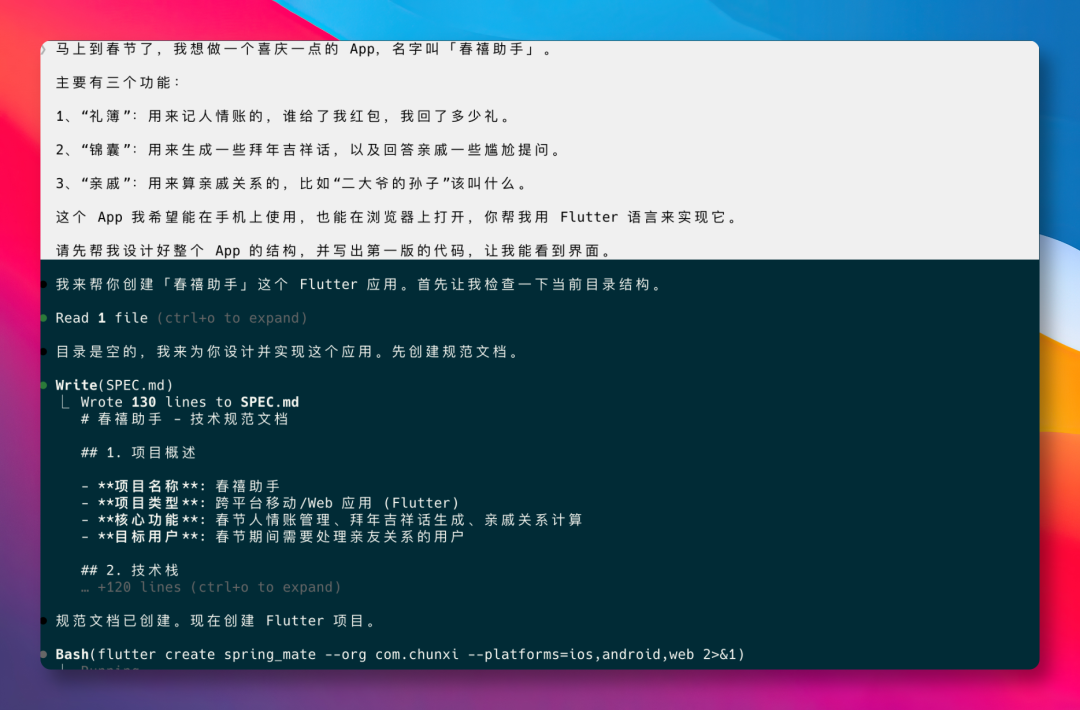

我用自然语言Prompt发起挑战,要求M2.5用Flutter开发春节主题跨端App“春禧助手”(含礼簿、锦囊、亲戚关系计算三大功能),全程未写一行代码,实测表现超出预期:

1.UI设计:审美在线,贴合场景需求

仅通过“喜庆一点”的模糊指令,M2.5便生成春节红+流金色的质感界面,采用圆角卡片、纹理背景与磨砂玻璃效果,避免大红大绿的俗套设计,在10B参数量级中展现出罕见的审美理解能力。首页清晰呈现礼金收支统计,视觉层次分明,交互逻辑直观。

2.后端逻辑:全栈闭环,数据持久化落地

“锦囊”模块中,M2.5成功实现本地数据持久化与模型API调用,支持亲戚尴尬提问的幽默化回应(如“舅妈问有女朋友了吗”,回应“正在‘候机’,缘分飞机还没起飞”),且支持数据增删改查,跑通完整前后端逻辑,体现“智能体原生架构”的优势。

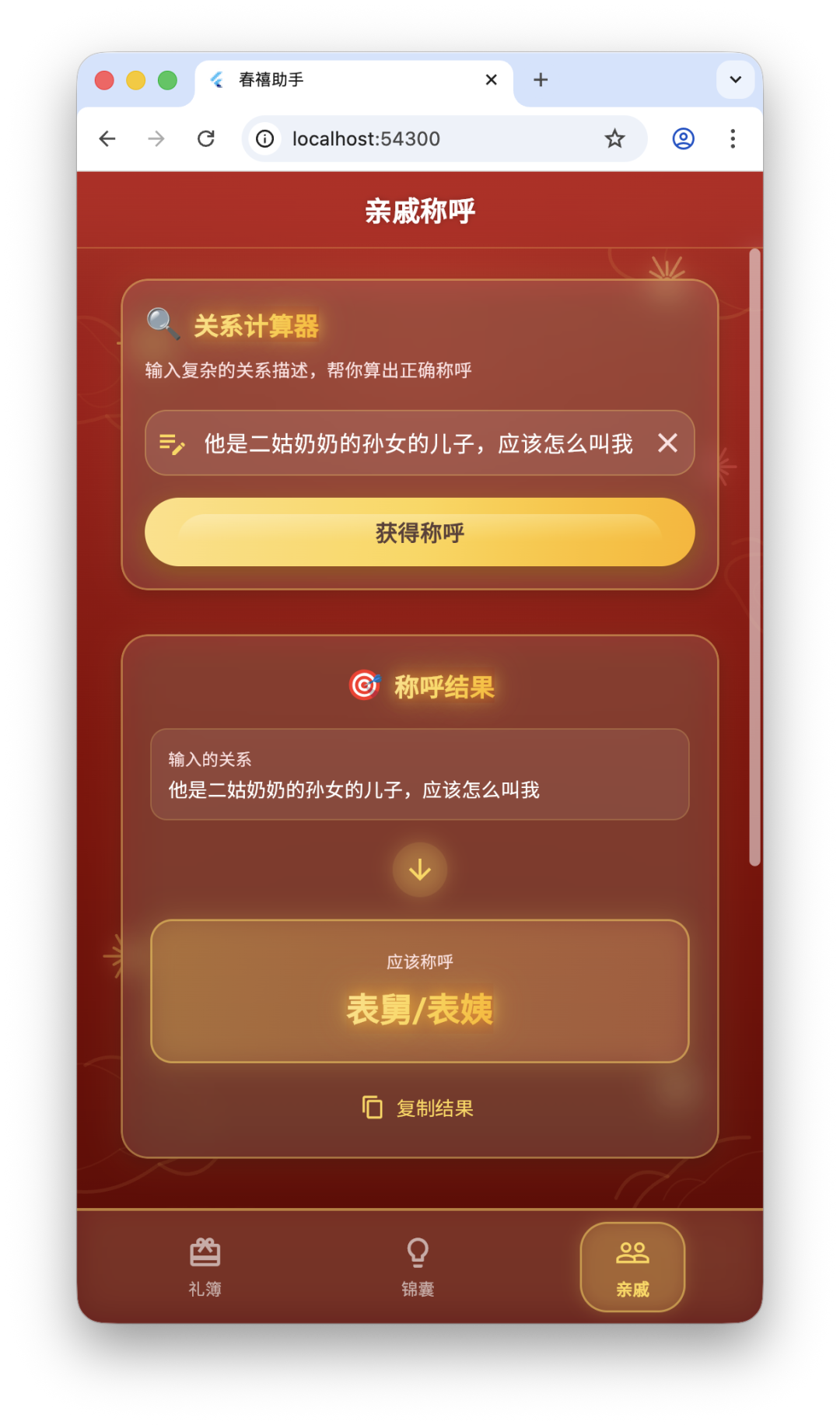

3.复杂推理:秒级响应,准确率超竞品

“亲戚”模块聚焦复杂关系计算,针对“二姑奶奶的孙女的儿子该怎么叫我”的绕弯提问,M2.5瞬时给出“表舅/表姨”的正确答案,而Claude Opus 4.6虽推理过程详细,结果却出现辈分判断错误,凸显M2.5在逻辑推理上的精准性。

4.跨端适配:三端兼容,交互接近原生

开发的App可直接在Chrome浏览器运行,经简单配置后,在iOS端完美适配,左滑删除等交互操作与原生应用无差异,验证了其跨端开发的实用性与稳定性。

三、行业意义:AI下半场转向“快、准、低成本”

M2.5的发布标志着AI行业风向从“卷参数大小”转向“务实落地”,其核心价值在于:

催生“AI超级个体”:独立开发者可凭借极低成本、极快速度打通产品从0到1的闭环,高频试错迭代,缩小与大企业的开发差距;

夯实智能体生态基础设施:押注Agent-verse赛道,以轻量化、低成本特性为下一阶段Agent互联网模式铺路;

重塑开发成本结构:让中小企业无需承担高昂算力与Token消耗,即可将AI接入工作流、App或私有服务器,推动AI技术普惠。

作为聚焦效率与落地性的国产大模型,MiniMax M2.5以“小参数、大能力”的反差表现,为编程领域带来新选择,尤其适合需要跨端开发、快速迭代、注重隐私安全的开发者与企业,有望成为AI开发下半场的核心基础设施之一。

0

好文章,需要你的鼓励