ai建模是怎么做的?确实不是一个简单的事情

总听人说AI建模多复杂,好像得是技术大神才会?其实没那么玄乎,把步骤拆开来,你会发现它跟搭积木有点像,关键是知道每一步要做啥。

给AI建模投喂数据

AI建模第一步,得先给它准备“吃的”——也就是数据。AI要学“认东西”“做判断”,也得先看足够多的数据。

数据质量比数量更重要。比如有些数据缺了值(比如天气数据里某天的湿度没记录),得补上;有些数据是错的(比如把“30℃”写成了“300℃”),得删掉。

标注工作真的很枯燥,但又不能马虎。我的建议是可以先用一些自动标注工具做预处理,然后人工检查修正。Label Studio、Roboflow这些平台都挺好用的,界面友好,支持多种数据类型。

选择合适的AI建模架构

模型架构的选择要根据具体任务来定。

做图像识别?CNN是经典选择。

处理文本?Transformer系列更合适。

时序数据分析?LSTM或者GRU可能是更好的选项。

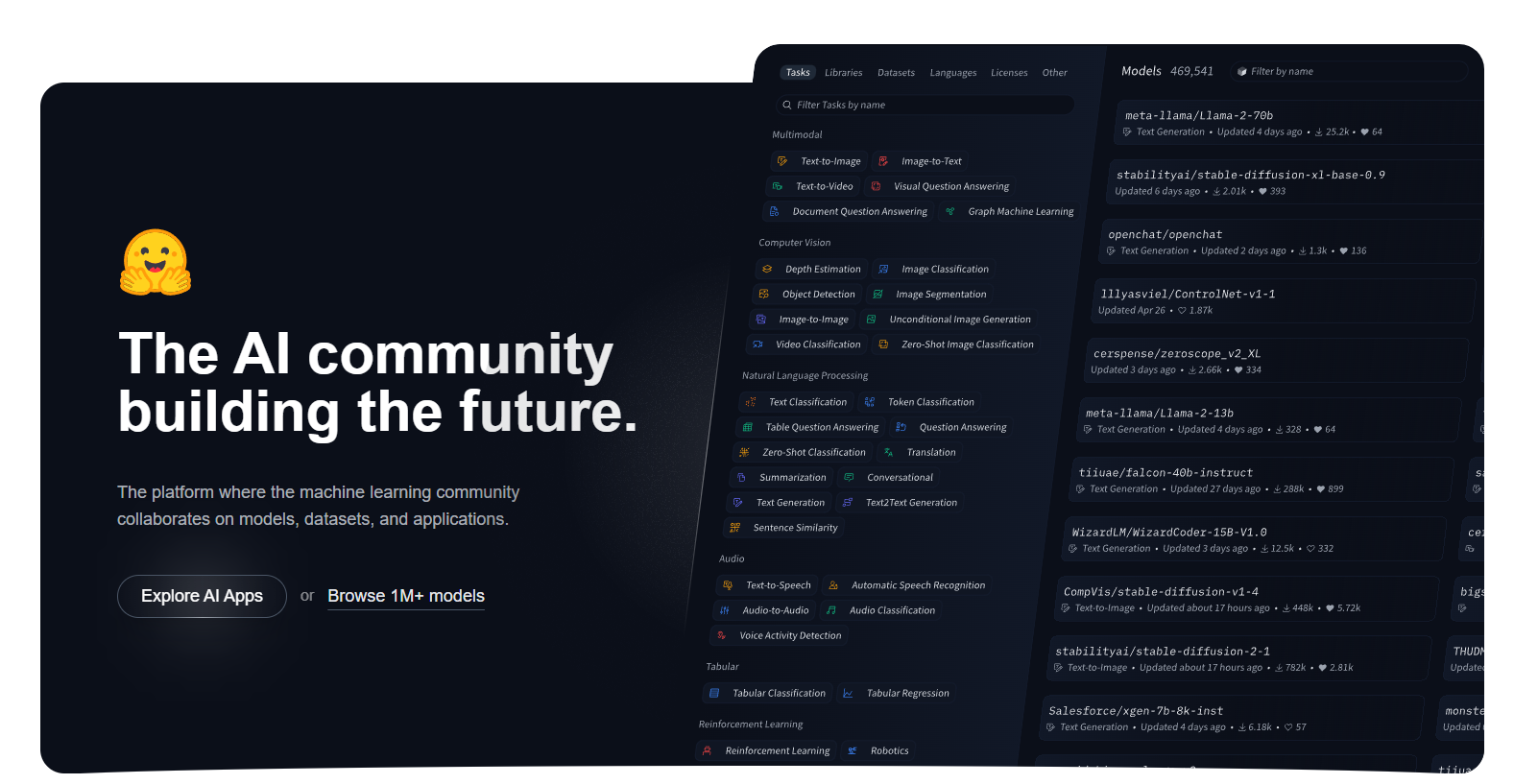

我个人比较喜欢从预训练模型开始。现在Hugging Face上有大量现成的模型,你可以直接拿来fine-tune,省去从头训练的时间。ResNet、BERT、GPT这些经典架构的预训练版本都能找到,而且文档齐全。

如果从头训练CNN,根本不够用。但用ImageNet预训练的ResNet做迁移学习,效果出奇的好。

AI建模训练技巧

训练过程中有几个关键点要注意。学习率调整是个技术活,太大容易震荡,太小收敛太慢。

建议大家用学习率衰减策略,开始设置得稍微大一点,然后随着训练进行逐步减小。

过拟合是个老大难问题。Dropout、批量归一化、数据增强都是常用的解决方法。我还喜欢用早停策略,监控验证集损失,连续几个epoch没有改善就停止训练。

GPU资源的合理利用也很重要。如果你的GPU内存有限,可以减小batch size,或者用梯度累积的技巧。Google Colab对个人用户来说是不错的选择,免费额度基本够做小项目了。

AI建模部署和优化

模型训练完成只是第一步,如何部署到生产环境才是真正的挑战。

模型压缩是必须考虑的。原始的深度学习模型通常都很大,直接部署不现实。量化、蒸馏、剪枝这些技术可以大幅减小模型尺寸,加快推理速度。我用过TensorRT做模型优化,效果挺明显的,推理速度能提升好几倍。

ONNX是个不错的中间格式,支持在不同框架间转换模型。你用PyTorch训练的模型可以转成ONNX,然后在生产环境用更高效的推理引擎运行。

API设计也要考虑周全。用户体验很重要,接口要简洁明了,错误处理要到位。我习惯用FastAPI搭建服务,自动生成文档,调试也方便。

在这里要注意数据漂移,这是个常见现象。模型在测试集上表现很好,部署到真实环境后效果下降。这通常是因为训练数据和实际数据分布不一致。

所以监控模型性能,定期重新训练是必要的。

AI建模确实不是一个简单的事情,需要在实践中不断学习和调整,希望以上的内容能帮助你理解ai建模是怎么做的。