ai写作网会雷同吗?安全吗?

最近看到不少人在问AI写作工具的事儿,特别是担心内容会不会撞车、数据安全不安全。作为一个在AI圈子里混了几年的人,今天就跟你聊聊这个话题。

ai写作会雷同吗?

如果你就是简单地输入"写一篇关于春天的文章",那确实,十个人用十个AI工具可能写出来的调性都差不多——都是那种"春暖花开,万物复苏"的套路。

但问题不在AI,在于你给的指令太笼统了。就好比你去饭馆说"给我来个菜",厨师也不知道你想吃啥对吧?

用同一个AI工具,分别输入很详细的要求和很简单的要求,结果必定是天差地别。

详细的那个,或许加了具体的角度、想要的语气、甚至举了几个例子,出来的文章就很有特色。而简单指令那个,可能真的很模板化。

现在主流的AI写作平台,像Claude、GPT-4这些,它们的模型本身就有随机性。同样的问题问两遍,答案都不会完全一样。

这是因为模型在生成文字时,每次选择下一个词都带有一定的概率分布,不是死板地输出固定答案。

什么情况下容易雷同

如果你用AI写的是那种标准化内容,比如产品说明书、新闻稿件之类的,那确实可能和别人的内容相似度高一些。因为这类文章本来就有固定的格式和必须包含的信息点,就算是人写也都差不多。

要是创意类的内容,像故事、评论、个人见解这种,只要你懂得怎么引导AI,加入你自己的想法和素材,雷同的概率其实挺低的。

还有个现象挺有意思的——很多人觉得AI写的东西雷同,其实是因为大家都在用差不多的提示词模板。

网上流传的那些"万能提示词",你用我用大家用,那当然会产生类似的输出。这就像照着同一个菜谱做菜,味道能差到哪去?

ai写作数据安全吗?

这个问题确实很关键,你把内容输入到AI平台,它会不会泄露?会不会被拿去训练模型?会不会有一天你的商业机密就被AI"吐"给别人了?

不同平台的政策差别挺大的,一些大厂的商业版产品,像OpenAI的企业版、Claude的Pro版,他们会明确承诺不用你的数据训练模型。

但免费版就说不准了,很多平台会在条款里写明可能会使用用户输入来改进服务。

你得仔细看看用户协议,虽然我知道没几个人会真的去看那一堆法律术语。

ai写作如何既不雷同又安全?

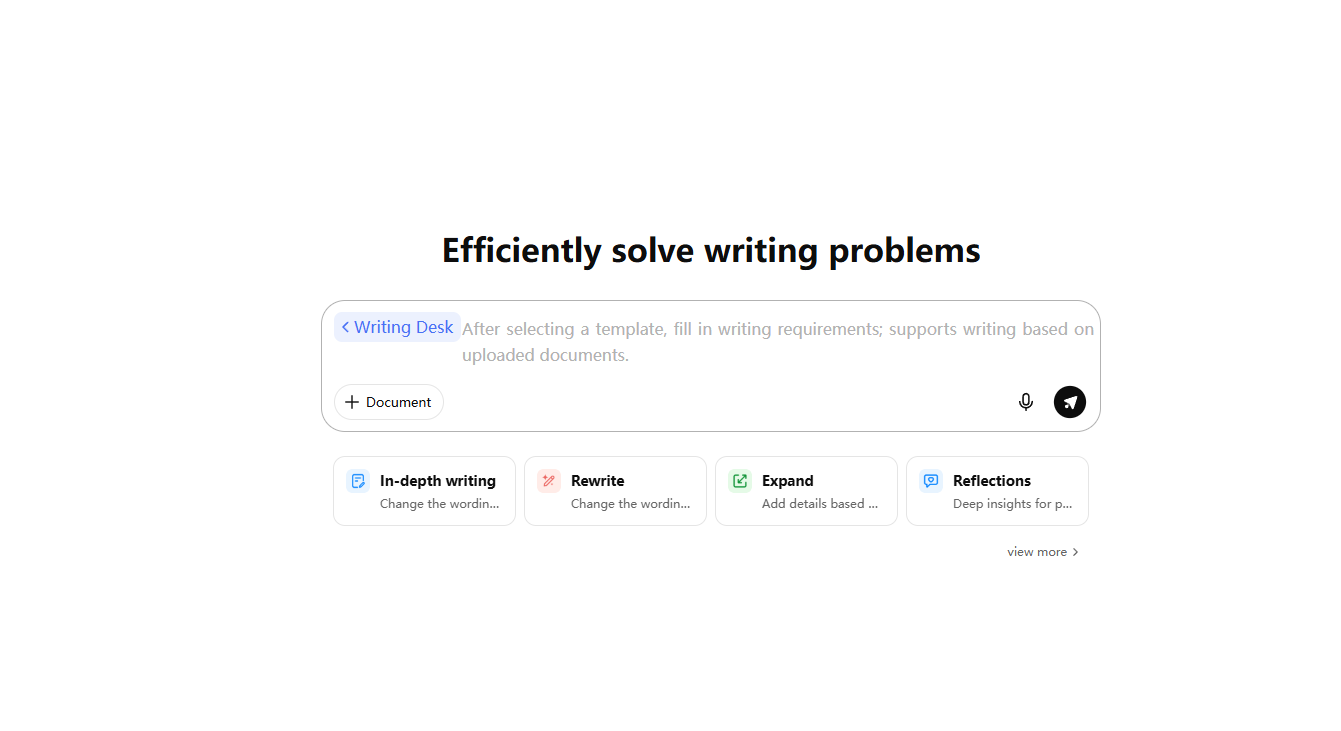

想让AI写的内容独一份,第一步就是把提示词写细。

别只说“写一篇旅游攻略”,要具体到“写青岛三日游攻略,突出老城区的小众咖啡馆,加我在海边踩水的趣事,语气像和朋友聊天”,提示词越精准,AI越能贴合你的需求。

写完之后,一定要自己“加工”,比如加一段自己的真实经历,改几个口头禅,把长句拆成短句,比如AI写的“青岛的海鲜新鲜美味”,改成“青岛的海鲜真的绝了!刚捞上来的虾,白灼一下就超鲜,连壳都想嚼了”,瞬间就摆脱模板感。

安全方面,优先选有大厂背书的平台,这些平台的隐私政策更规范,不会随便泄露用户信息。

如果写的内容比较敏感,比如商业计划书,写完后可以用平台的“本地保存”功能,别存在平台云端。

还有个小细节,注册账号时别用真实姓名当昵称,绑定手机号就行,减少个人信息暴露的风险。

AI写作工具本身是中性的,关键看你怎么用。雷同不雷同取决于你的输入质量和创意,安全不安全取决于你选择的平台和使用习惯。